论文标题:Distilling Knowledge via Knowledge Review

论文链接:https://arxiv.org/abs/2104.09044

代码链接:https://github.com/Jia-Research-Lab/ReviewKD

作者单位:香港中文大学(贾佳亚团队) & 思谋科技 & 牛津大学

提出Review机制,表现SOTA!性能优于OFD、VID和FGFI等网络,将其应用于分类,检测和分割任务上,学生网络性能都显著提高!代码即将开源!

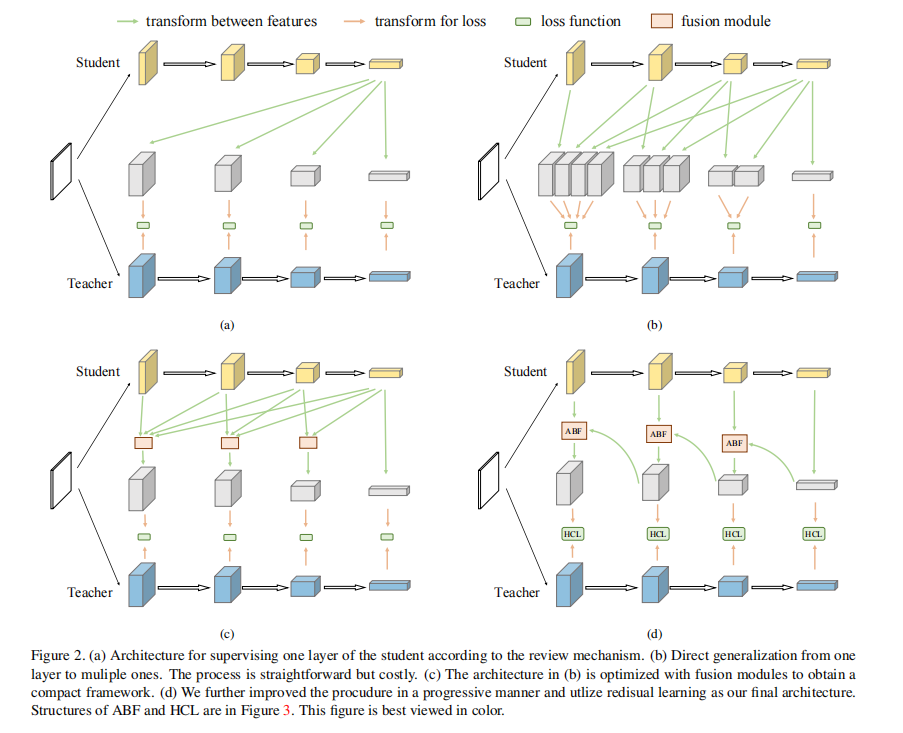

知识蒸馏将知识从教师网络迁移到学生网络,目的是大大提高学生网络的性能。先前的方法主要着重于提出相同级别的特征之间的特征变换和损失函数以提高有效性。 我们以不同的方式研究师生网络之间连接路径跨层次的因素,并揭示了它的重要性。 在知识蒸馏中,第一次提出了跨阶段的连接路径。我们新的review机制有效且结构简单。 我们最终设计的嵌套且紧凑的框架所需的计算开销可忽略不计,并且在各种任务上都优于其他方法。我们将我们的方法应用于分类,目标检测和实例分割任务。 所有这些都见证了学生网络性能的显著提高。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢