【论文标题】

【作者团队】

【发表时间】2021/04/16

【机 构】

【论文链接】https://arxiv.org/pdf/2103.03547v4.pdf

【推荐理由】贝叶斯主动学习与预训练的融合,未来将在各种数据成本高的场景上有所发挥

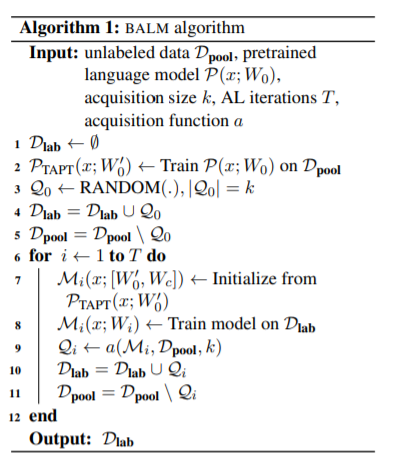

学习()进行了的。然中的学习,这并不能有的。本文学习这些。作者提出可用数据的学习。作者一个微的,将oot下,采样信的,与的比M在数据上提升。下图为贝叶斯主动学习的算法。

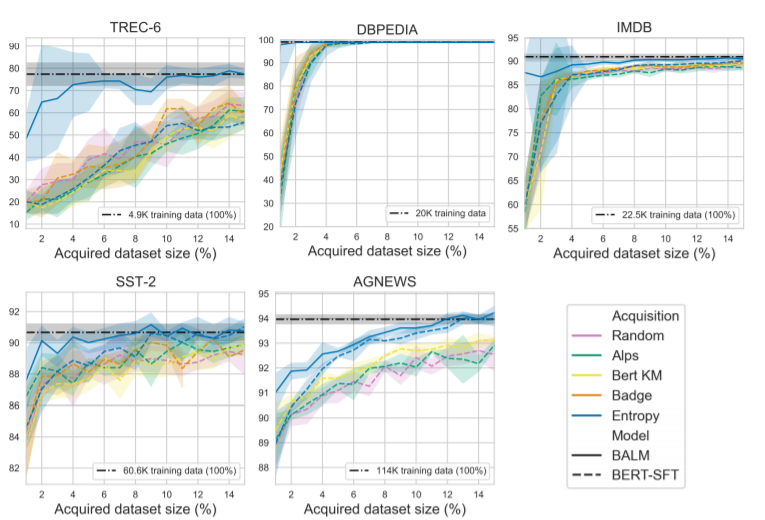

本文在acquisition function中比较了以下几种,相关函数代码来自https://github.com/forest-snow/alps:

1. Random

2. Entropy,根据Entropy计算公式选取熵值最高结果进行采样

3. BADGE, 根据loss梯度的多样性进行采样

4. BERT-KM(ALPS),使用K-Means聚类l2正则化的预训练BERT-embedding并且对聚类中心样本进行采样,该方法与ALPS除去使用预训练embedding之外,完全一样

5. FT-BERT-KM,与上文的BERT-KM使用的embedding为fine-tune后的模型隐变量,其他一模一样

下图为在不同数据集上结果,虚线为BERT-finetuning的标准操作,实线为结合了贝叶斯主动学习后的结果,可以发现优于传统预训练方法。同时,在acquisition function上Entropy表现较好。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢