【论文标题】 Towards Long-Term Fairness in Recommendation

【作者团队】Yingqiang Ge, Shuchang Liu, Ruoyuan Gao, Yikun Xian, Yunqi Li, et al.

【发表时间】2021-01-10

【机构】Rutgers University, Michigan State University, Alibaba Group

【论文连接】https://arxiv.org/abs/2101.03584

【推荐理由】公平性问题在推荐系统中重要性极高。传统上解决公平性问题的方法都基于静态的、独热的配置,模型仅基于约束公平性的优化方法来提供单次公平性解决方案,这忽视了推荐系统中的动态变化。本文对此问题提出了动态公平性学习方法——约束公平性的强化学习算法。通过将推荐问题建模为一个约束马尔可夫决策过程(CMDP)使得模型可动态调节推荐策略,在环境变化时也能满足公平性需求。最后,作者在几个现实世界的数据集上做了关于推荐性能、短期公平性和长期公平性的模型测试,均取得了不错的效果。

作者将动态公平性定义为环境中的动态因素,需要学习一个可适应这些动态因素的策略。长期公平性的目标是达到长时间内的动态公平性。推荐系统中关于条目曝光度的长期公平性的主要难题是,条目将会根据推荐策略和用户反馈的不同收到不同程度的曝光度。团队提出并解决了以下三个问题:1. 在推荐场景中,如何建模那些带有变化组别标签的条目曝光度的长期公平性?2. 如何根据实时条目曝光度和用户交互来更新推荐策略?3. 如何在大尺度数据集上高效优化策略?

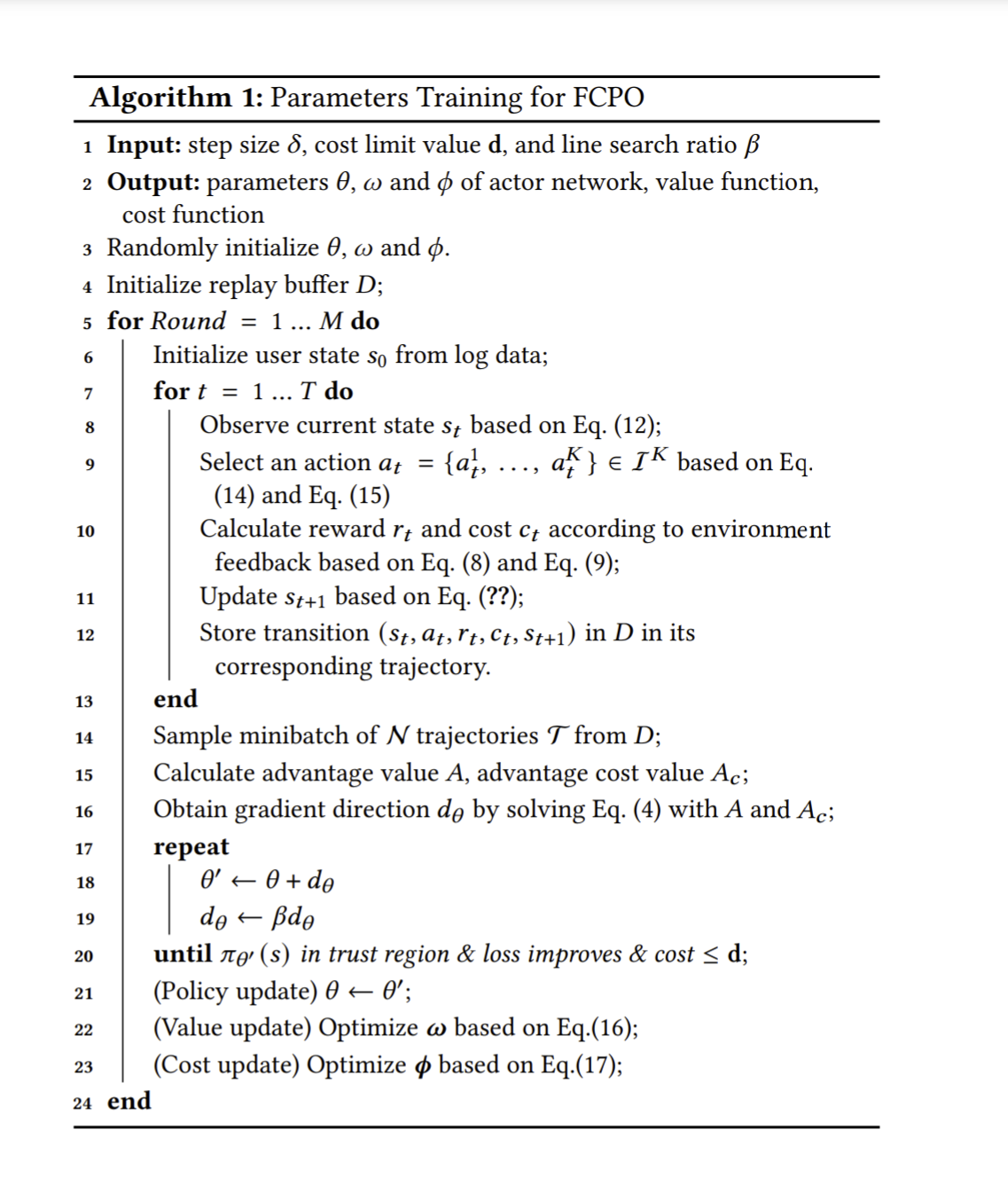

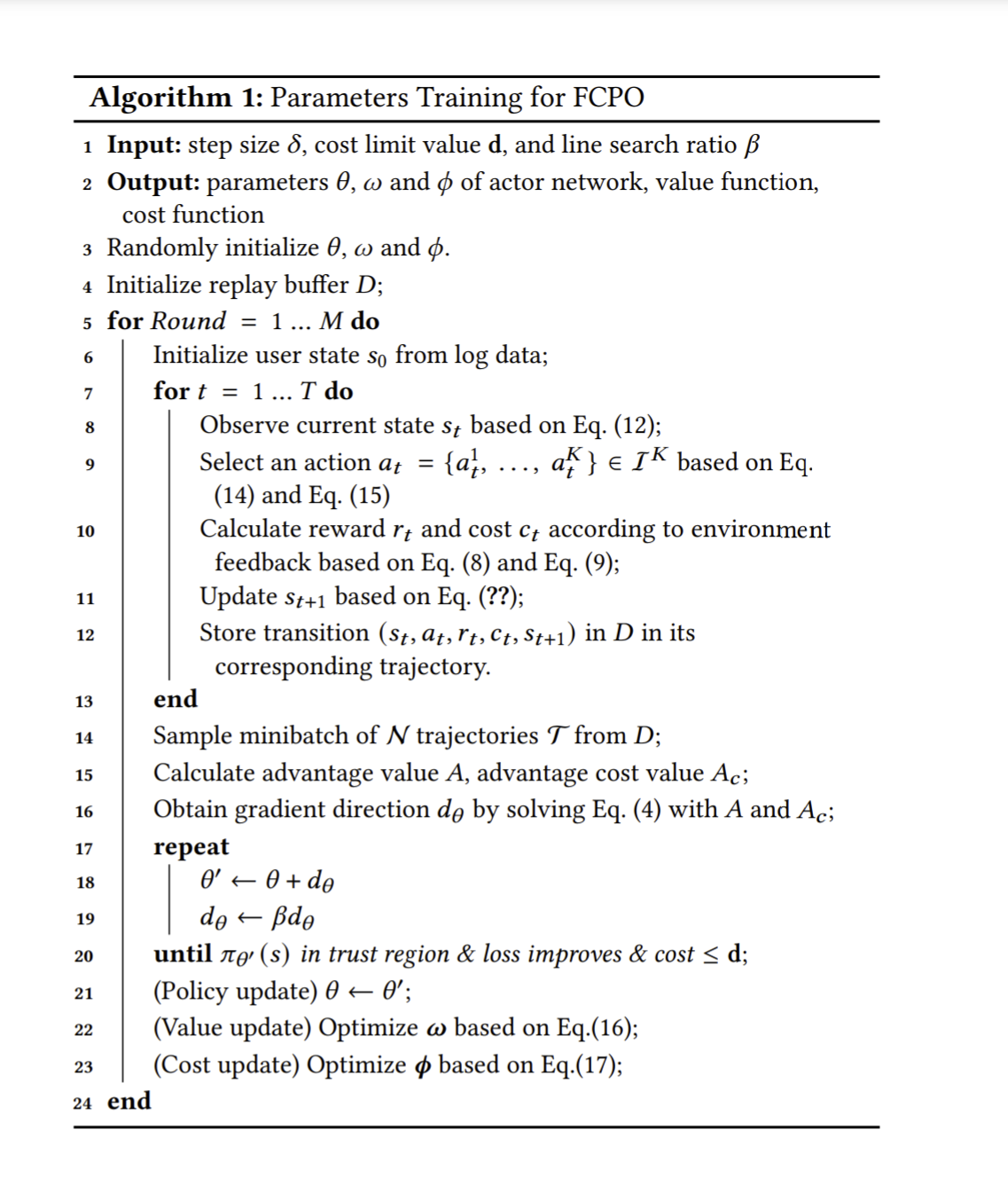

作者对推荐系统的和消费者间的序列交互建模为CMDP,又根据公平性约束模型和公平性约束策略优化模型FCPO,将其加入Actor-Critic结构,形成了如下训练算法:

研究团队在Movielens100K和Movielens1M数据集上测试了FCPO模型,并与传统方法和基于RL方法的基准做了对比:MF,BPR-MPF,NCF,LIRD,并将MF-FOE,BPR-FOE和NCF-FOE作为公平性基准线来进行测试。实验结果详见论文。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢