绿色安全游戏(GSG)已被成功用于 保护有价值的资源,如渔业、森林和野生动物。虽然现实世界的部署涉及到资源分配和随后的协调巡逻与通信和实时的不确定信息,但以前的游戏模型并没有同时完全解决这两个阶段。此外,采用现有的解决策略是困难的,因为它们不能很好地扩展到更大、更复杂的游戏模型变体。因此,我们首先提出了一个新颖的GSG模型,该模型结合了防御者分配、巡逻、实时无人机通知人类巡逻者,以及无人机向攻击者发送警告信号。该模型进一步纳入了无人机和人类巡逻者团队中实时决策的不确定性。第二,我们提出了CombSGPO,一种基于强化学习的新型可扩展算法,用于计算该游戏模型的防御者策略。CombSGPO在一个多维的、离散的行动空间中进行策略搜索,以计算出最适合于防御者的最佳反应巡逻策略的分配策略,该策略是通过训练一个多代理的深度Q网络学习的。我们通过实验表明,CombSGPO能收敛到更好的策略,并且比同类方法更具可扩展性。第三,我们对CombSGPO学习到的协调和信号行为进行了详细的分析,显示了防御者资源之间的分组和基于资源之间信号和通知的巡逻队形。重要的是,我们发现在最终学习的策略中出现了战略信号。最后,我们进行了实验,以评估这些战略在不同的不确定性水平下的情况。

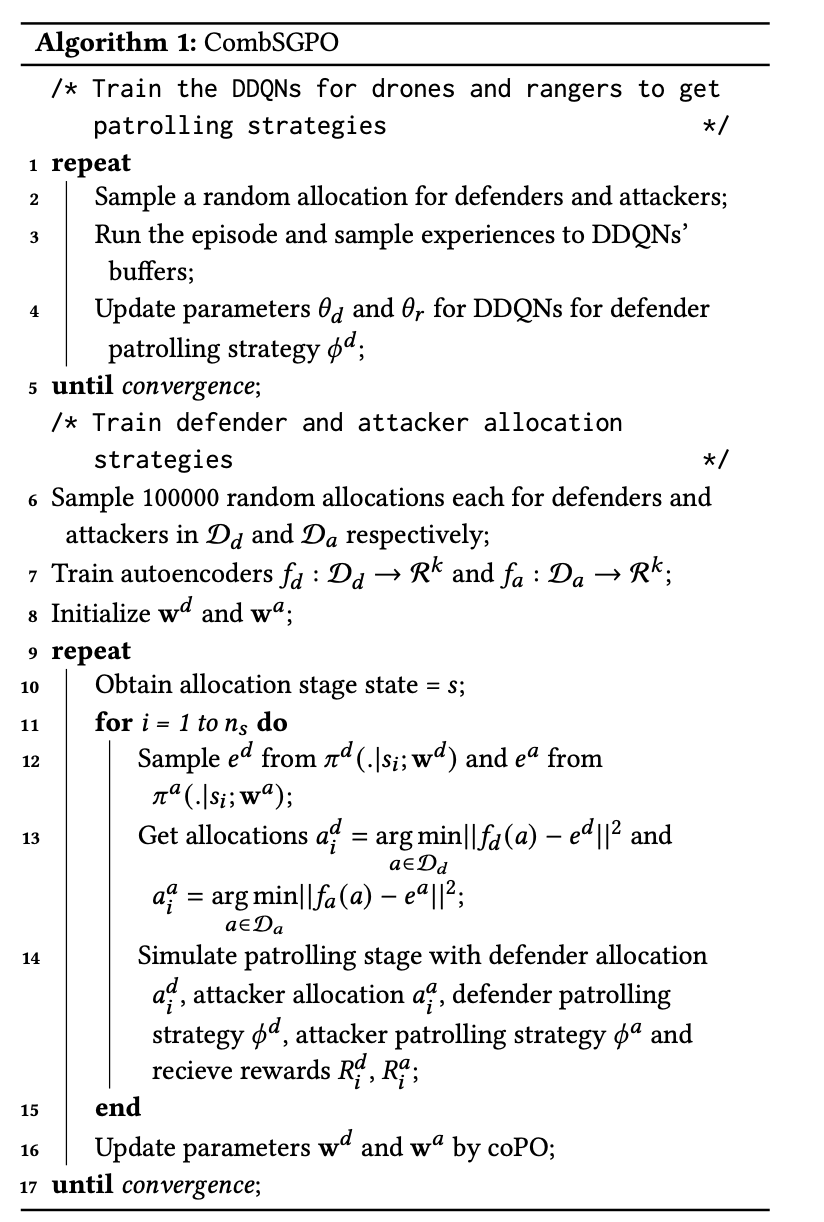

CombSGPO 算法描述如下:

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢