论文标题:Aligning Subtitles in Sign Language Videos

论文链接:https://arxiv.org/abs/2105.02877

主页链接:https://www.robots.ox.ac.uk/~vgg/research/bslalign/

作者单位:巴黎萨克雷大学 & 牛津大学

本手语-字幕自动对齐模型通过提供持续同步的视频文本数据,为推进手语的机器翻译开辟了可能性!

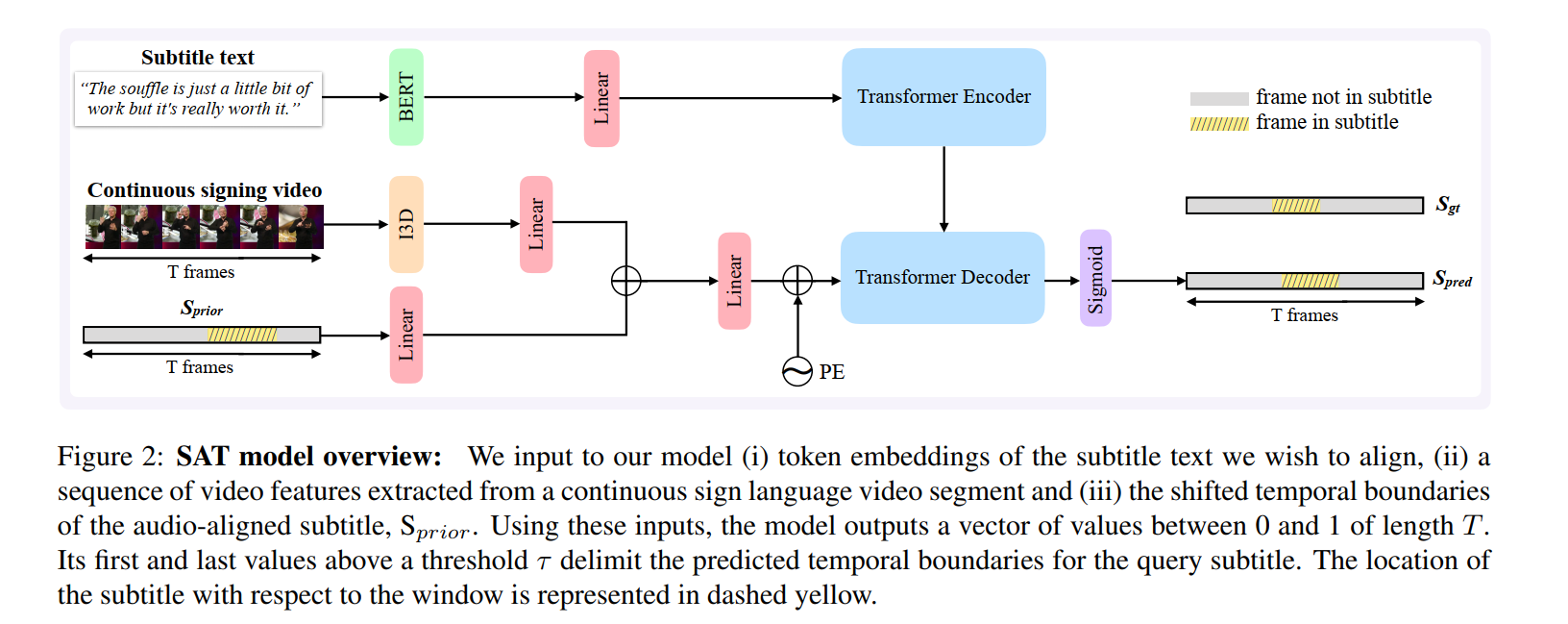

这项工作的目标是在手语视频中临时对齐异步字幕。特别地,我们专注于由手语解释的电视广播数据,包括(i)连续的手语视频,和(ii)对应于音频内容的字幕。以前利用这种弱对齐数据的工作仅考虑查找关键字与符号的对应关系,而我们的目标是在连续手语中定位完整的字幕文本。我们提出了针对此任务量身定制的Transformer体系结构,我们对其进行了人工注释的对齐方式进行了相邻,该对齐方式涵盖了跨越17.7个小时的视频的超过15K字幕。我们将学习的BERT字幕嵌入和CNN视频表示形式用于手势识别,以对这两个信号进行编码,这两个信号会通过一系列注意层进行交互。我们的模型输出帧级预测,即,对于每个视频帧,无论它是否属于所查询的字幕,都将输出。通过广泛的评估,我们显示出在不使用字幕文本嵌入进行学习的情况下对现有对齐基准进行的重大改进。我们的自动对齐模型通过提供持续同步的视频文本数据,为推进手语的机器翻译开辟了可能性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢