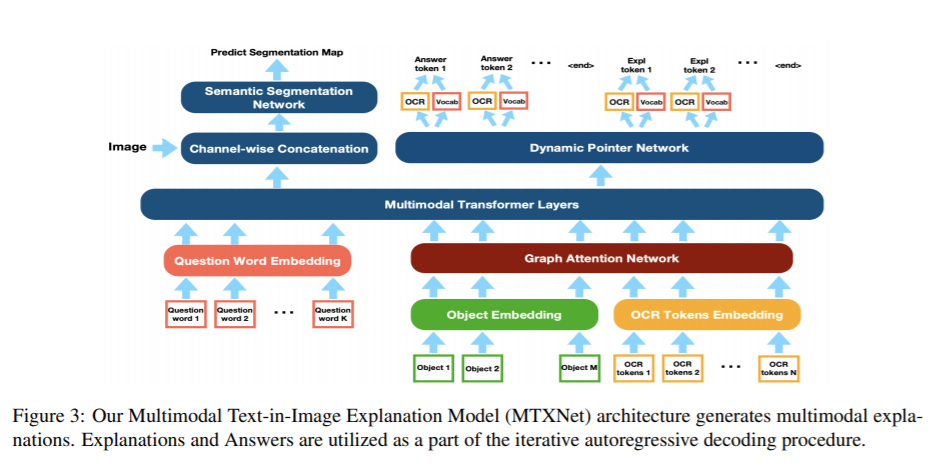

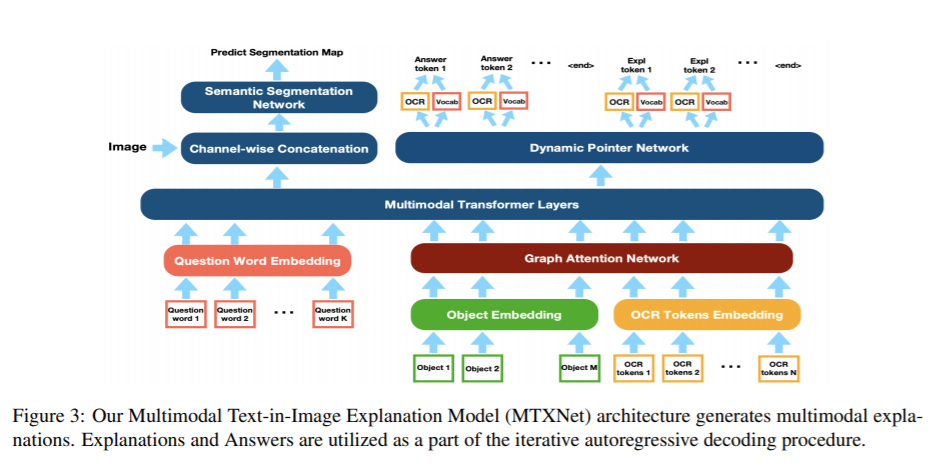

标题:亚马逊、威斯康星大学麦迪逊分校|A First Look: Towards Explainable TextVQA Models via Visual and Textual Explanations(初步了解:基于视觉和文本解释性的可解释的文本视频问答模型)

https://arxiv.org/pdf/2105.02626.pdf

数据集:https://github.com/amzn/explainable-text-vqa

内容中包含的图片若涉及版权问题,请及时与我们联系删除

https://arxiv.org/pdf/2105.02626.pdf

数据集:https://github.com/amzn/explainable-text-vqa

内容中包含的图片若涉及版权问题,请及时与我们联系删除

沙发等你来抢

评论

沙发等你来抢