【论文标题】An Efficient Learning Framework For Federated XGBoost Using Secret Sharing And Distributed Optimization

【作者团队】 Lunchen Xie, Jiaqi Liu, Songtao Lu, Tsung-hui Chang, Qingjiang Shi

【发表时间】2021/05/12

【机 构】同济大学,软件学院

【论文链接】https://arxiv.org/pdf/2105.05717.pdf

【推荐理由】本文出自同济大学,针对现有的联合XGBoost(FedXGB)模型仍然存在数据泄漏问题,通信和计算开销较大,本文提出一种具有安全性保证的无损多方联合XGB学习框架,并通过分布式优化解决了叶子权重计算问题。

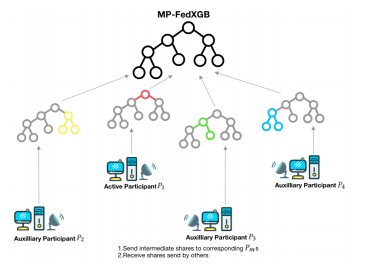

XGBoost具有卓越的学习准确性和效率,是业界使用最广泛的机器学习模型之一。 针对大数据问题中的数据隔离问题,部署安全高效的联合XGBoost(FedXGB)模型至关重要。 现有的FedXGB模型要么存在数据泄漏问题,要么仅适用于通信和计算开销较大的两方设置。本文提出了一种具有安全性保证的无损多方联合XGB学习框架,该框架重塑了XGBoost在秘密共享设置下的拆分标准计算过程,并通过分布式优化解决了叶子权重计算问题。值得注意的是,还提供了对模型安全性的透彻分析,并且多个数值结果表明,与基准数据集上的最新模型相比,建议的FedXGB具有优越性。

本文的主要贡献如下三点:

1)MP-FedXGB是第一个在SS设置下以高效和可扩展性对垂直分区数据进行多方联合XGB学习的框架。

2)提出了一种简单但非常有效的计算整形方法,用于计算分割标准和叶权重,从而大大提高了训练效率,同时保留了数据安全性和隐私性。

3)为了完全解决潜在的实例空间泄漏问题,本文为框架提出了一种称为First-Layer-Mask的额外安全机制,从而进一步增强了框架的安全性。

图1 联合XGB学习架构图

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢