【论文标题】Investigating Math Word Problems using Pretrained Multilingual Language Models

【作者团队】Minghuan Tan, Lei Wang, Lingxiao Jiang, Jing Jiang

【发表时间】2021/05/19

【机 构】Singapore Management University

【论文链接】https://arxiv.org/pdf/2105.08928v1.pdf

【推荐理由】预训练与数学逻辑

本文从跨语言和多语言的角度重新审视数学文字问题(MWP)。作者使用带有复制机制的序列到序列模型,在预训练好的多语言模型上构建了MWP解算器并比较了MWP求解器在跨语言和多语言情况下的表现。为了便于比较跨语言的性能,作者首先将大规模的英文数据集MathQA改编为中文数据集Math23K的对应数据。然后,作者通过机器翻译和人工注释将几个英语数据集扩展为双语数据集。本文的实验表明,即使目标表达式具有相同的运算符集和常数,MWP求解器也可能无法转移到不同的语言中。但是对于跨语言和多语言的情况,如果源语言和目标语言上都存在该问题类型,那么它可以更好地被泛化。

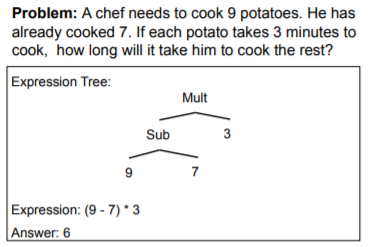

上图为数学文字问题(应用题)的求解过程简单示例

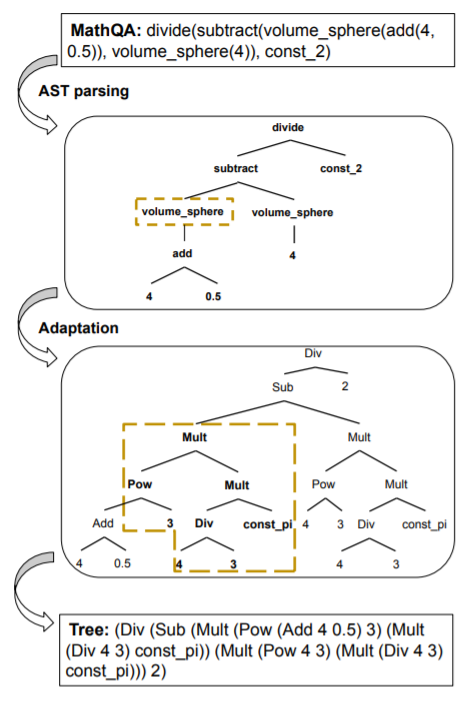

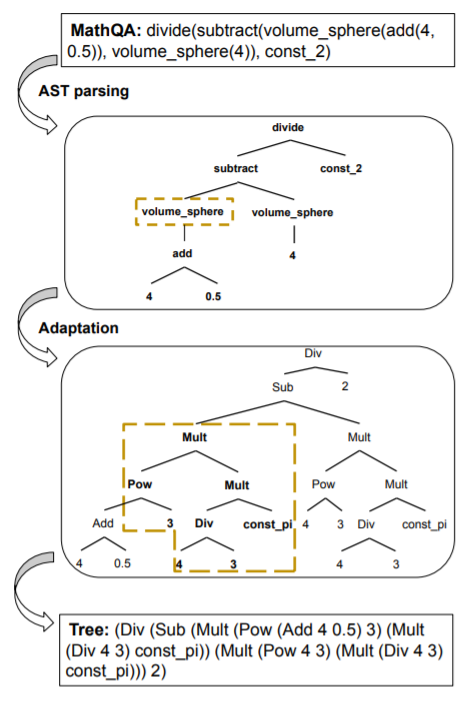

上图为从MathQA到Math23K的注释架构转换实例,关键被圈起来的部分为被转换的函数:volume_sphere

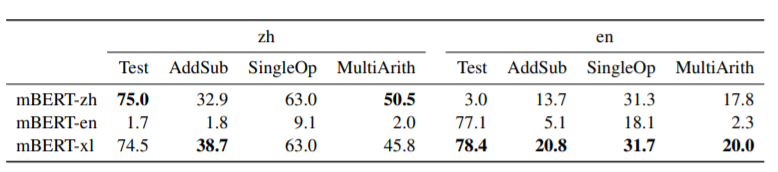

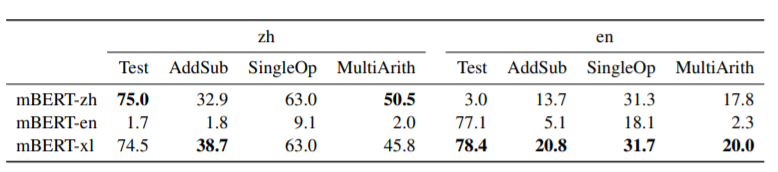

不同语言及多语言模型mBERT-xl在中英文场景下比较的结果,而可以看的xl模型均有所效果。这印证了作者的观点,对于跨语言和多语言的情况,如果源语言和目标语言上都存在该问题类型,那么它可以更好地被泛化。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢