【论文标题】StyTr2 : Unbiased Image Style Transfer with Transformers

【作者团队】Yingying Deng, Fan Tang, Xingjia Pan, Weiming Dong,Chongyang Ma, Changsheng Xu

【机构】中国科学院大学,快手科技

【发表时间】2021/6/2

【论文链接】https://arxiv.org/pdf/2105.14576.pdf

【推荐理由】

本文针对图像风格迁移任务中,传统CNN方法由于局部性和空间不变性的特点导致网络难以提取和维护输入图像的全局信息,进而在图像艺术渲染中存在不足,即传统的CNN网络风格迁移方法存在偏差导致图像艺术渲染效果不好的问题,提出了StyTr2:使用 Transformer 进行无偏图像风格迁移的方法。

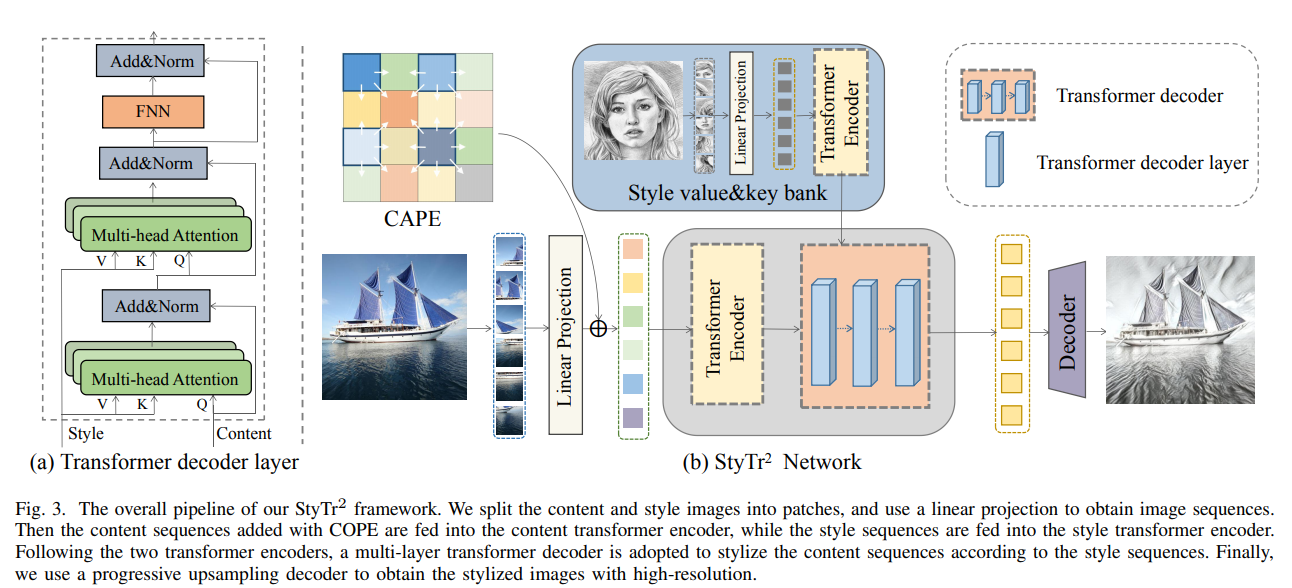

StyTr2方法将输入图像的长期依赖考虑到无偏风格转移,包含两个不同的transformer编码器,分别为内容和样式生成特定于领域的序列。在编码器之后,采用多层transformer解码器根据样式序列对内容序列进行样式化。此外,作者还分析了现有位置编码方法的不足,提出了尺度不变且更适合图像风格迁移任务的内容感知位置编码(CAPE)。StyTr2的结构示意图如图1所示。

图1: StyTr2结构示意图

在实验部分,作者基于定性和定量两种角度,分别比较了 StyTr2 和基于 CNN 方法的结果,验证了 StyTr2的有效性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢