论文标题:Attention-guided Temporal Coherent Video Object Matting

论文链接:https://arxiv.org/abs/2105.11427

代码链接:https://github.com/yunkezhang/TCVOM

作者单位:浙江大学 & 阿里巴巴

表现SOTA!性能优于GCA、STM等网络,并构建了一个视频物体分割新数据集:VideoMatting108,代码和数据集刚刚开源!

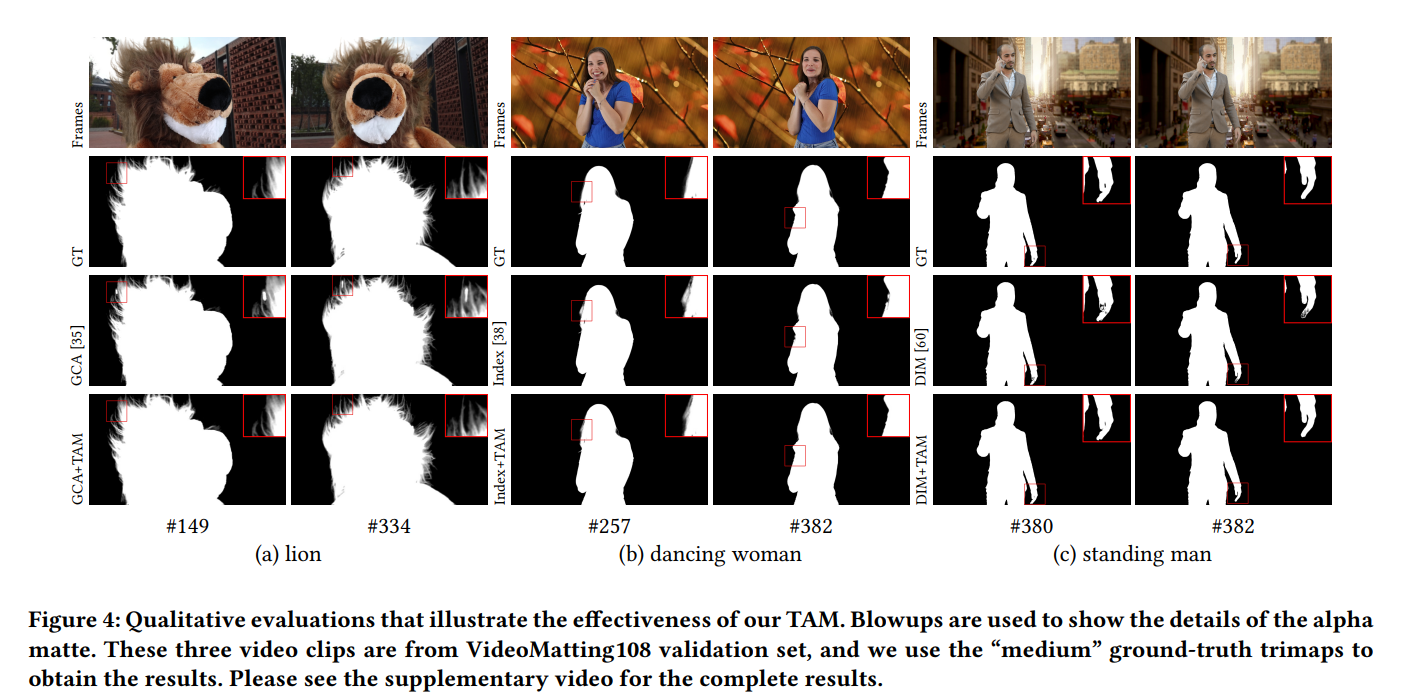

本文提出了一种新的基于深度学习的视频物体抠图(Video Object Matting)方法,可以实现时间相干抠图结果。它的关键组件是一个基于注意力的时间聚合模块,它可以最大限度地提高图像抠图网络对视频抠图网络的强度。该模块计算特征空间中沿时间轴彼此相邻的像素的时间相关性,以对运动噪声具有鲁棒性。我们还设计了一个新颖的损失项来训练注意力权重,这大大提高了视频抠图性能。此外,我们展示了如何通过使用一组稀疏的用户注释关键帧微调最先进的视频目标分割网络来有效解决trimap 生成问题。为了促进视频抠图和trimap生成网络的训练,我们构建了一个大规模的视频抠图数据集,其中包含 80 个训练和 28 个验证前景视频剪辑,带有ground-truth alpha 遮罩。实验结果表明,我们的方法可以为具有外观变化、遮挡和快速运动的各种视频生成高质量的 alpha 遮罩。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢