【论文标题】CAT: Cross Attention in Vision Transformer

【作者团队】Hezheng Lin, Xing Cheng,Xiangyu Wu,Fan Yang,Dong Shen,Zhongyuan Wang,Qing Song,Wei Yuan

【机构】快手,北京邮电大学

【发表时间】2021/6/11

【论文链接】https://arxiv.org/pdf/2106.05786.pdf

【推荐理由】

本文针对视觉Transformer中,用图像块替换单词标记所需的计算量非常大的问题,提出了视觉Transformer中的交叉注意力方法(CAT)。

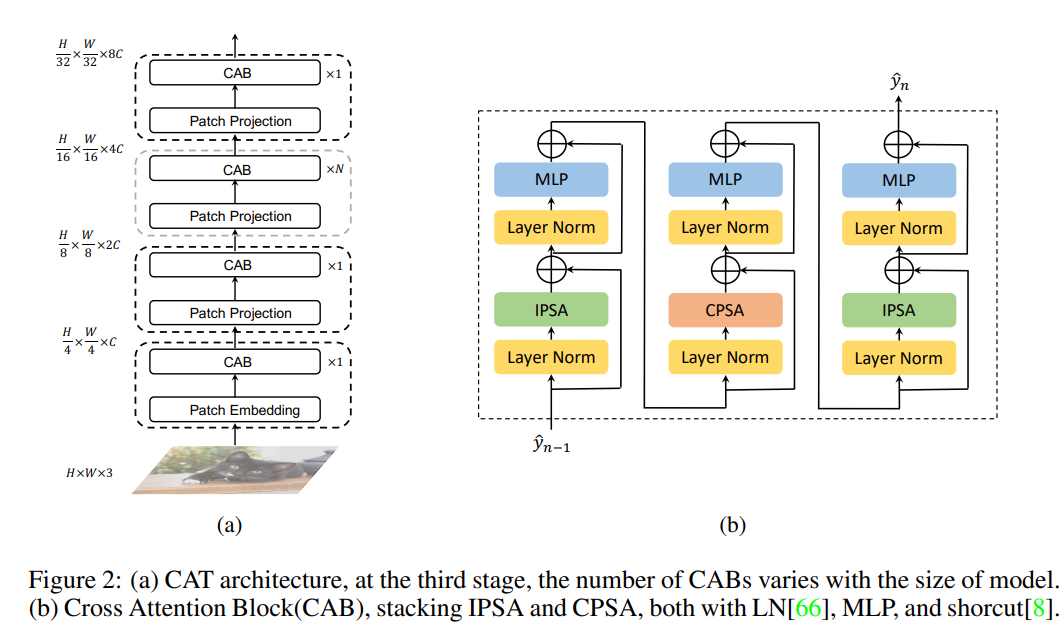

CAT在图像块内部交替注意来获取局部信息,在单通道特征图划分的图像块之间应用注意来获取全局信息,这两种操作的计算量都小于Transformer中的标准自我注意。通过交替应用注意内贴片和注意间贴片,实现了交叉注意力,以较低的计算成本保持性能,并为其他视觉任务构建了一个称为交叉注意力Transformer(CAT)的层次网络。CAT的结构示意图如图1所示。

实验过程中,CAT在ImageNet-1K上达到了最先进的水平,并在COCO和ADE20K上改进了其他方法的性能,说明CAT网络有潜力成为通用主干网。

图1:CAT结构示意图

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢