论文标题:Learning by Distillation: A Self-Supervised Learning Framework for Optical Flow Estimation

论文链接:https://arxiv.org/abs/2106.04195

作者单位:香港中文大学 & 虎牙AI

DistillFlow:一种以知识蒸馏方式有效学习光流的自监督学习方法,在KITTI等数据集上表现SOTA!性能优于SelFlow、ScopeFlow等网络。

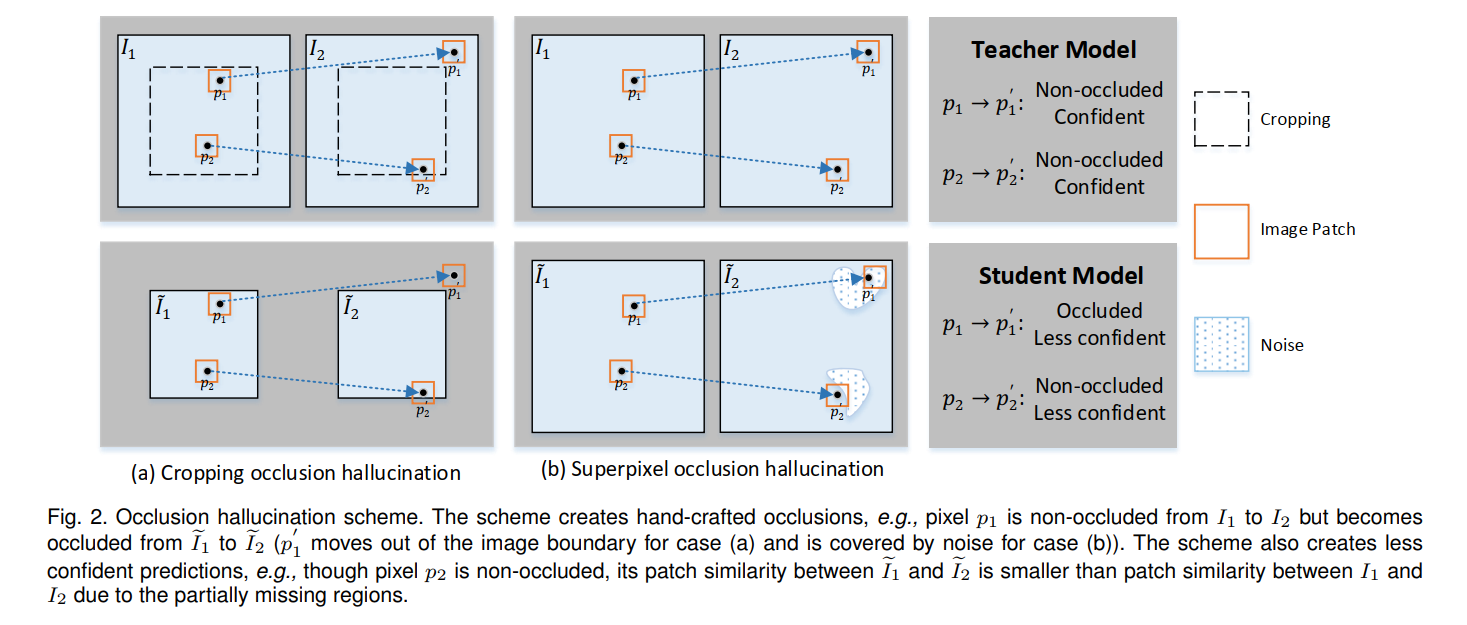

我们提出了 DistillFlow,这是一种学习光流的知识蒸馏方法。DistillFlow 训练多个教师模型和学生模型,其中将具有挑战性的转换应用于学生模型的输入以生成幻觉遮挡以及不太自信的预测。然后,构建了一个自监督学习框架:来自教师模型的自信预测被用作注释,以指导学生模型为那些不太自信的预测学习光流。自监督学习框架使我们能够从未标记的数据中有效地学习光流,不仅适用于非遮挡像素,还适用于遮挡像素。 DistillFlow 在 KITTI 和 Sintel 数据集上实现了最先进的无监督学习性能。我们的自监督预训练模型还为监督微调提供了出色的初始化,这表明与当前高度依赖合成数据预训练的监督学习方法相比,这是一种替代训练范式。在撰写本文时,我们的微调模型在 KITTI 2015 基准测试的所有单目方法中排名第一,并且在 Sintel Final 基准测试中的表现优于所有已发布的方法。更重要的是,我们在三个方面展示了 DistillFlow 的泛化能力:框架泛化、对应泛化和跨数据集泛化。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢