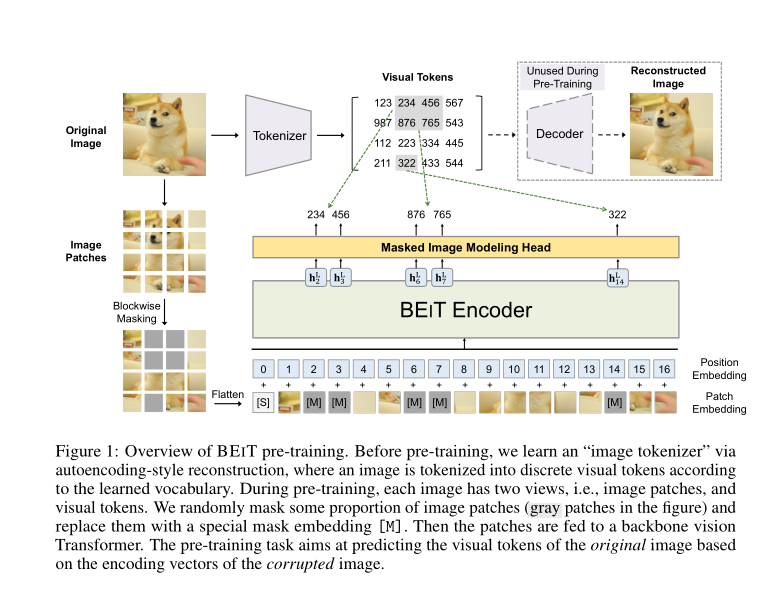

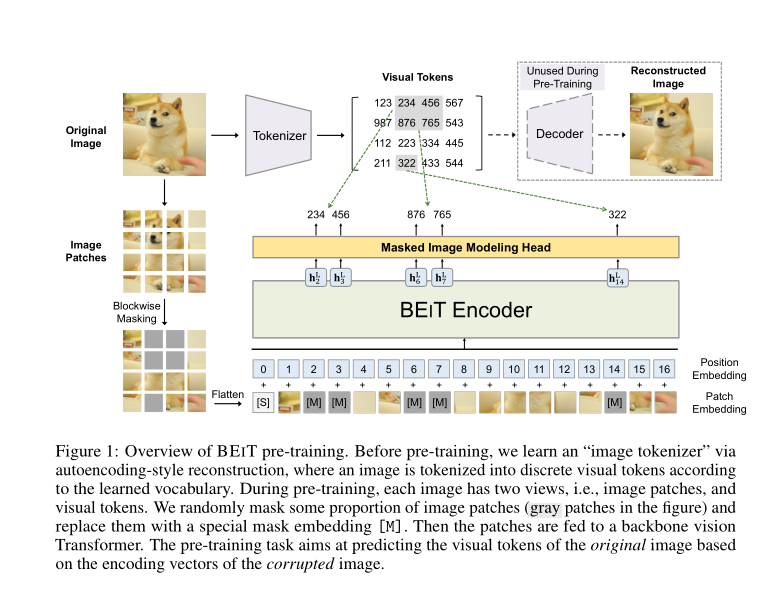

标题:微软|BEIT: BERT Pre-Training of Image Transformers(BEIT:BERT 图像变换器预训练)

https://github.com/microsoft/unilm/tree/master/beit

https://arxiv.org/pdf/2106.08254v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

https://github.com/microsoft/unilm/tree/master/beit

https://arxiv.org/pdf/2106.08254v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

沙发等你来抢

评论

沙发等你来抢