论文标题:HR-NAS: Searching Efficient High-Resolution Neural Architectures with Lightweight Transformers

论文链接:https://arxiv.org/abs/2106.06560

代码链接:https://github.com/dingmyu/HR-NAS

作者单位:香港大学 & 字节跳动 & 中国人民大学

本文提出一种轻量级、即插即用的Transformer,它可以轻松地与卷积网络结合,为密集图像预测任务丰富全局上下文,轻松助力分类、分割等任务涨点!代码刚刚开源!

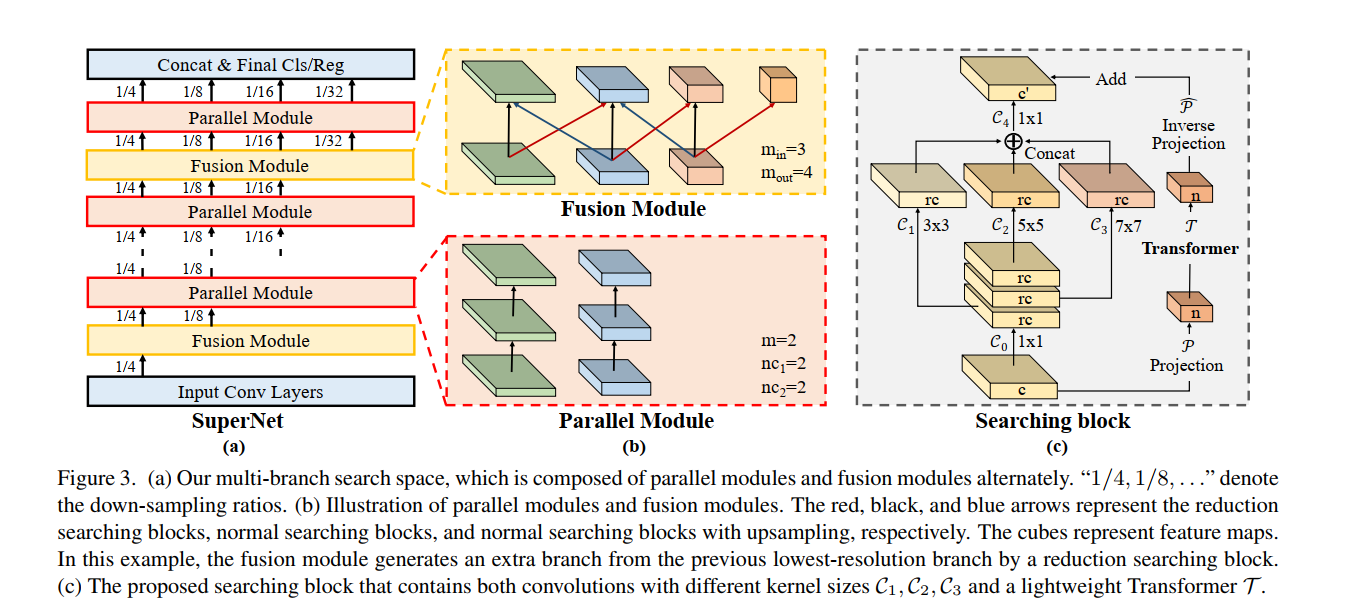

高分辨率表示 (HR) 对于密集预测任务(例如分割、检测和姿态估计)至关重要。在以前专注于图像分类的神经架构搜索 (NAS) 方法中,学习 HR 表示通常被忽略。这项工作提出了一种新的 NAS 方法,称为 HR-NAS,它能够通过有效地编码多尺度上下文信息同时保持高分辨率表示,为不同的任务找到有效和准确的网络。在 HR-NAS 中,我们更新了 NAS 搜索空间及其搜索策略。为了在 HR-NAS 的搜索空间中更好地编码多尺度图像上下文,我们首先精心设计了一个轻量级转换器,其计算复杂度可以根据不同的目标函数和计算预算动态改变。为了保持学习网络的高分辨率表示,HR-NAS 采用多分支架构,受 HRNet 的启发,提供多个特征分辨率的卷积编码。最后,我们提出了一种有效的细粒度搜索策略来训练 HR-NAS,它有效地探索搜索空间,并在给定各种任务和计算资源的情况下找到最佳架构。 HR-NAS 能够在三个密集预测任务和一个图像分类任务的性能和 FLOP 之间实现最先进的权衡,只要计算预算很小。例如,HR-NAS 超越了专为语义分割而设计的 SqueezeNAS,同时提高了 45.9% 的效率。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢