论文标题:GIRAFFE: Representing Scenes as Compositional Generative Neural Feature Fields

论文链接:https://arxiv.org/abs/2011.12100

代码链接:https://github.com/autonomousvision/giraffe

作者单位:马克思·普朗克智能系统研究所 & 图宾根大学

GIRAFFE:一种用于可控图像合成/场景生成的新方法!关键思想是将合成3D场景表示合并到生成模型中,并引入神经渲染,表现SOTA!性能优于GRAF、HoloGAN等网络,代码现已开源!

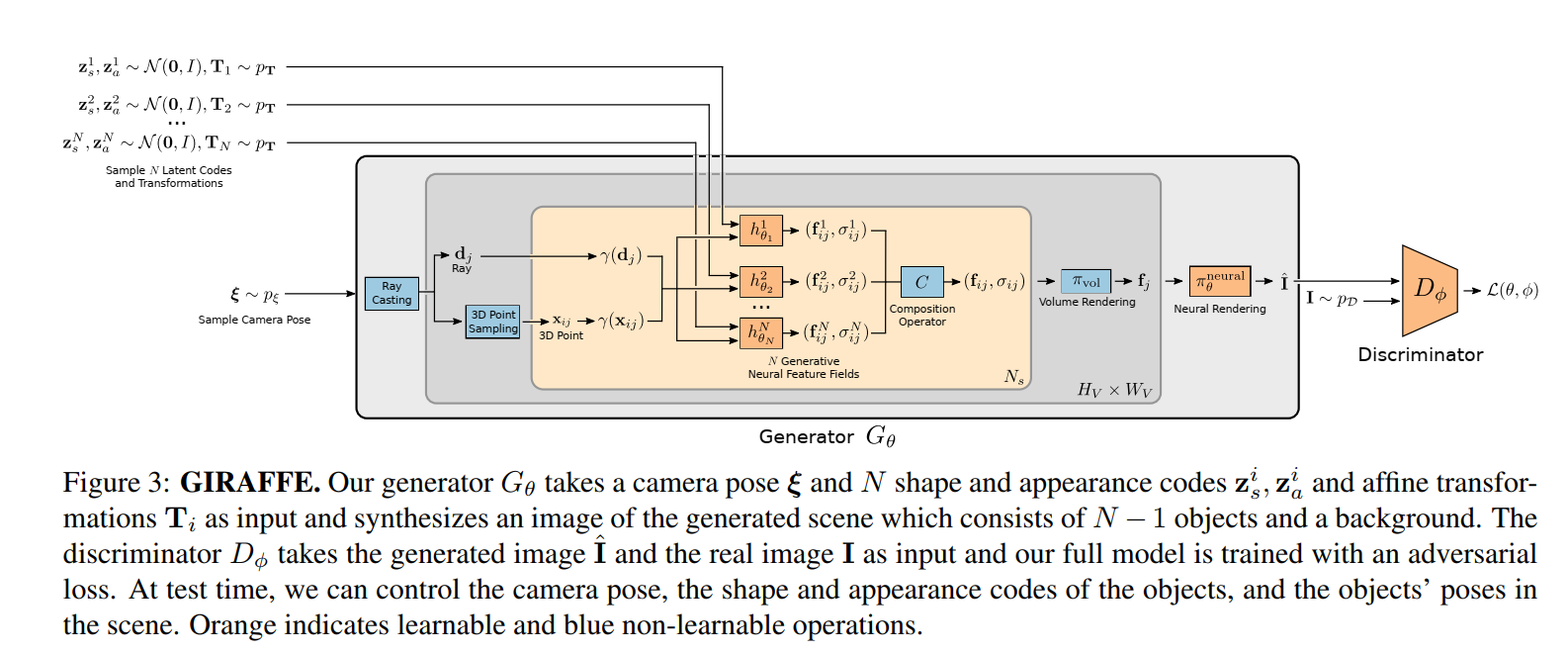

深度生成模型允许以高分辨率进行逼真的图像合成。但是对于许多应用程序来说,这还不够:内容创建还需要可控。虽然最近的几项工作研究了如何解开数据中变化的潜在因素,但大多数都是在 2D 中运行的,因此忽略了我们的世界是 3D 的。此外,只有少数作品考虑了场景的构图性质。我们的关键假设是将合成 3D 场景表示结合到生成模型中会导致更可控的图像合成。将场景表示为合成生成神经特征场使我们能够从背景中分离出一个或多个对象以及单个对象的形状和外观,同时从非结构化和未定位的图像集合中学习,而无需任何额外的监督。将此场景表示与神经渲染管道相结合,可以生成快速且逼真的图像合成模型。正如我们的实验所证明的那样,我们的模型能够解开单个物体,并允许在场景中平移和旋转它们以及改变相机姿势。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢