标题:清华、智源|CPM-2: Large-scale Cost-effective Pre-trained Language Models(CPM-2:大规模经济高效的预训练语言模型)

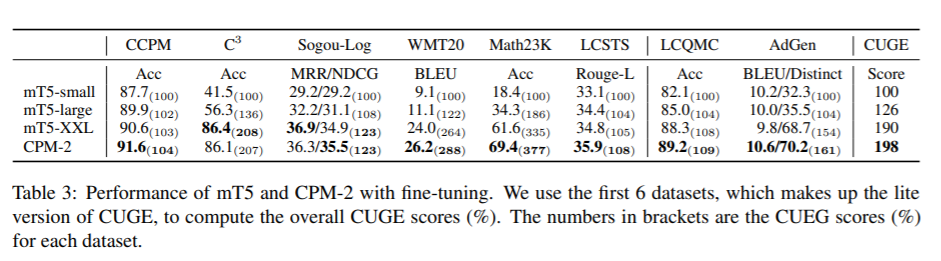

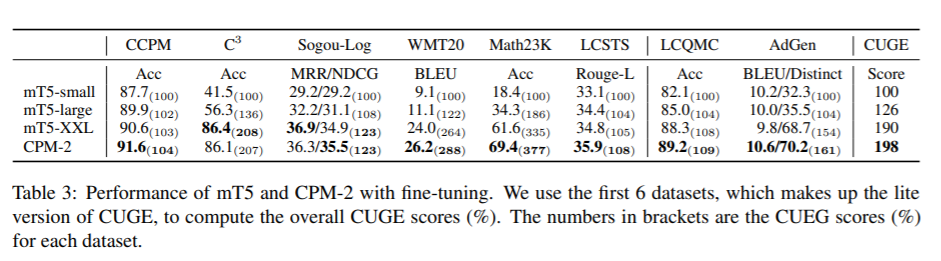

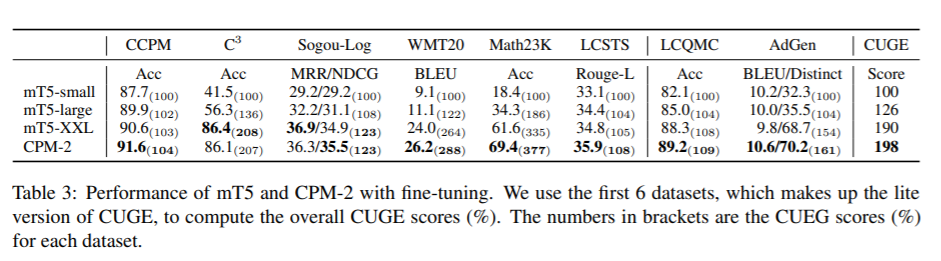

简介:近年来,预训练语言模型的规模突飞猛进。然而,大规模语言模型效率问题限制了它们在现实场景中的使用。我们提出了一套成本效益高的技术,用于使用处理预训练的效率问题,微调和推理。 (1) 介绍通过利用现有语言模型来加速预训练过程的知识继承而不是从头开始训练模型。 (2)我们探索了使用大规模语言模型进行即时调整的最佳实践。和....相比传统的微调、即时调优显着减少了任务特定参数的数量。 (3) 我们实现了一个新的推理工具包,即INFMOE,用于大规模使用具有有限计算资源的语言模型。基于我们具有成本效益的管道,我们预训练了两个模型:具有110亿个参数的编码器-解码器双语模型(CPM2)及其对应的1980亿个参数MoE版本。在我们的实验中,我们在下游比较了CPM-2和mT5任务。实验结果表明CPM2具有优秀的通用语言智能。此外,我们在单个GPU上对具有数百亿个参数的大规模模型进行推理时验证了INFMOE的效率。

代码地址:https://github.com/TsinghuaAI/CPM

论文下载:https://arxiv.org/pdf/2106.10715.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢