论文标题:CompConv: A Compact Convolution Module for Efficient Feature Learning

论文链接:https://arxiv.org/abs/2106.10486

单位:浙江大学 & 香港中文大学

为了降低CNN的计算成本,本文提出了一种新的卷积设计:CompConv。它利用分治法策略来简化特征图的转换。即插即用!可直接替换普通卷积,几乎不牺牲性能,极致压缩CNN结构!

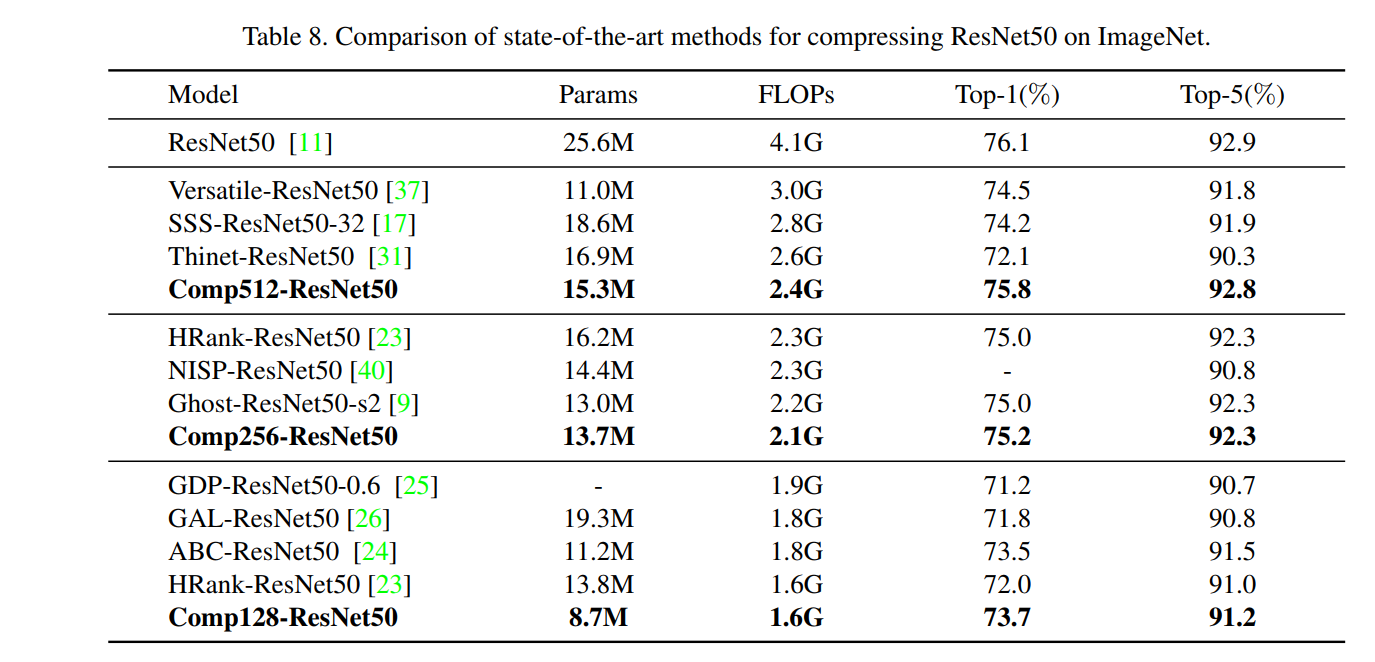

卷积神经网络 (CNN) 在各种计算机视觉任务中取得了显著的成功,但依赖于巨大的计算成本。为了解决这个问题,现有的方法要么压缩训练有素的大规模模型,要么学习具有精心设计的网络结构的轻量级模型。在这项工作中,我们仔细研究了卷积算子,这是 CNN 中使用的基本单元,以减少其计算负载。特别是,我们提出了一个紧凑的卷积模块,称为 CompConv,以促进高效的特征学习。通过分治法的策略,CompConv 能够节省大量的计算和参数来生成特定维度的特征图。此外,CompConv 将输入特征集成到输出中,以有效地继承输入信息。更重要的是,新颖的 CompConv 是一个即插即用模块,可以直接应用于现代 CNN 结构,无需进一步努力即可替换普通卷积层。大量的实验结果表明,CompConv 可以充分压缩基准 CNN 结构,同时几乎不牺牲性能,超越了其他竞争对手。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢