Hugging Face NLP 课程开课了,所有课程完全免费。

NLP 领域的小伙伴应该都非常熟悉大名鼎鼎的 Hugging Face,这家专注于解决各种 NLP 问题的初创公司为社区带来了很多有益的技术成果。去年,该团队的 Transformers 代码库论文获得了 EMNLP 2020 最佳 demo 奖。今年 4 月,该团队发布了适用于多 GPU、TPU 和混合精度训练的 PyTorch 新库「Accelerate」。

近日,Hugging Face 在其官方推特上宣布推出第一部分 NLP 课程,内容涵盖如何全面系统地使用 Hugging Face 的各类库(即 Transformers、Datasets、Tokenizers 和 Accelerate),以及 Hugging Face Hub 中的各种模型。更重要的是,所有课程完全免费且没有任何广告。

课程主页:https://huggingface.co/course/chapter0?fw=pt

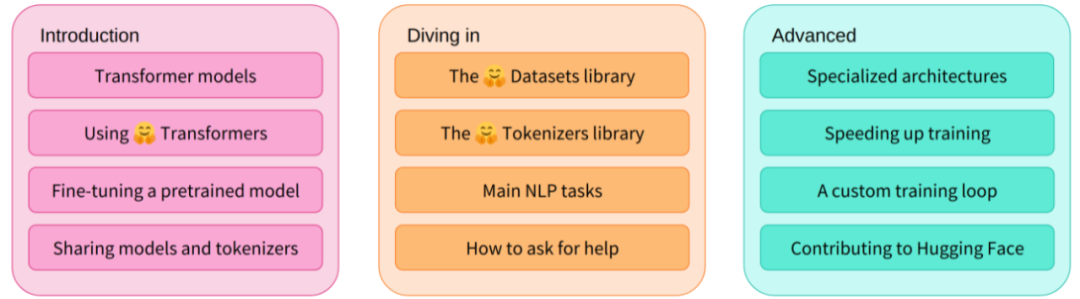

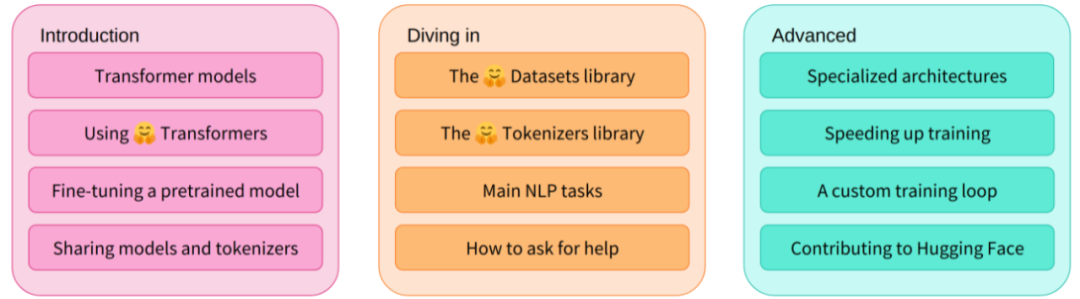

整个系列的课程分为入门(Introduction)、进阶(Diving in)和高级(Advanced),其中具体如下:

-

入门:Transformer 模型、使用 Transformers、微调预训练模型以及分享模型和 tokenizers;

-

进阶:Datasets 库、Tokenizers 库、主要 NLP 任务以及如何寻求帮助;

-

高级:专用架构、加速训练、自定义训练 loop 以及向 Hugging Face 提交贡献。

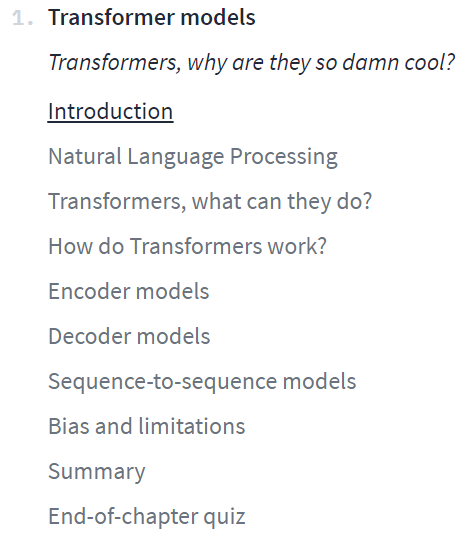

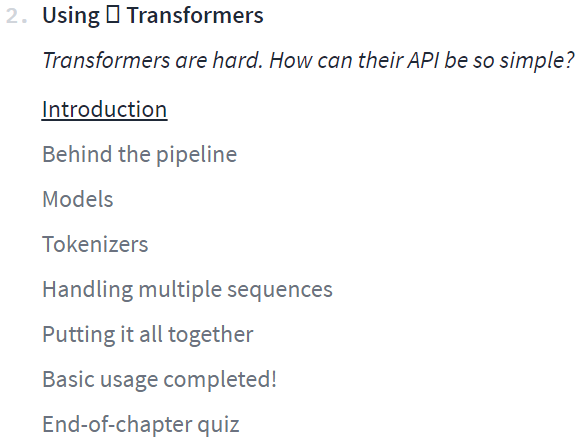

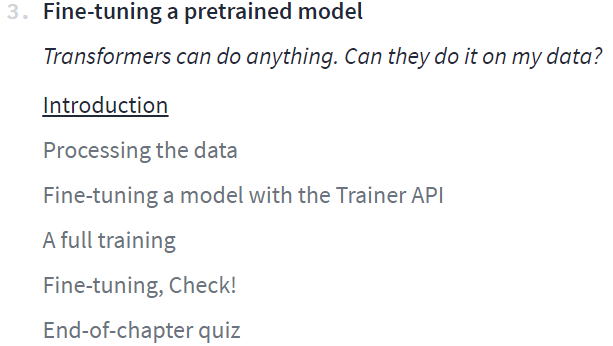

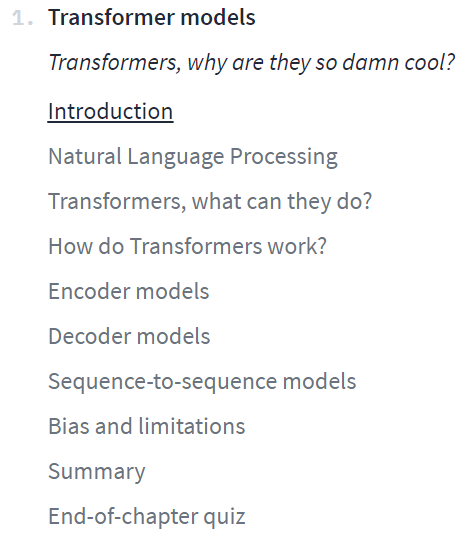

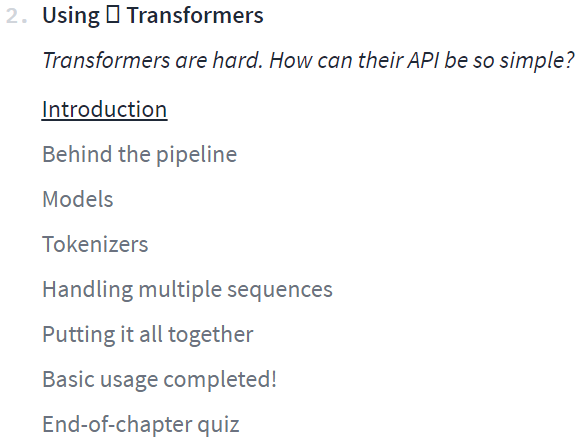

Hugging Face 本次推出的正是入门课程。通过四个章节的内容讲解,学习者可以学得使用 pipeline 函数来解决文本生成和分类等 NLP 任务、Transformer 架构,以及区分编码器、解码器、编码器 - 解码器架构和用例。

与此同时,Hugging Face 在课程中使用的所有库都可以通过 Python 包获得。学习者首先需要设置 Python 环境和安装专用库,并可以使用 Colab notebook 或 Python 虚拟环境来设置自己的工作环境。具体操作请参阅课程主页中的「setup」部分。

第 1 章到第 4 章(入门)介绍了 Transformers 库的主要概念。本部分课程结束时,你将熟悉 Transformer 模型的工作原理,并了解如何使用 Hugging Face Hub 中的模型,在数据集上对其进行微调,以及在 Hub 上共享结果。

第 5 章到第 8 章(进阶)介绍了在深入研究经典的 NLP 任务之前,首先介绍了数据集和 Tokenizers 的基础知识。本部分结束时,你将能够自己解决最常见的 NLP 问题。

第 9 章到第 12 章(高级),会进行深入的学习,展示了专业架构(内存效率,长序列等),并教你如何为用例编写自定义对象。在本部分结束时,你将会解决复杂的 NLP 问题。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢