标题:伯克利|ActNN: Reducing Training Memory Footprint via 2-Bit Activation Compressed Training(ActNN:减少训练内存占用通过2位激活压缩训练)

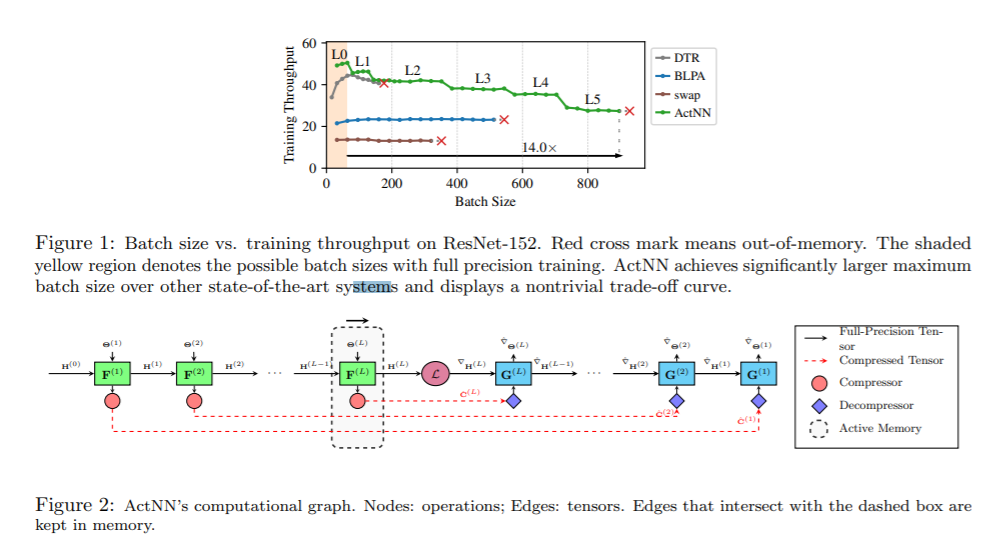

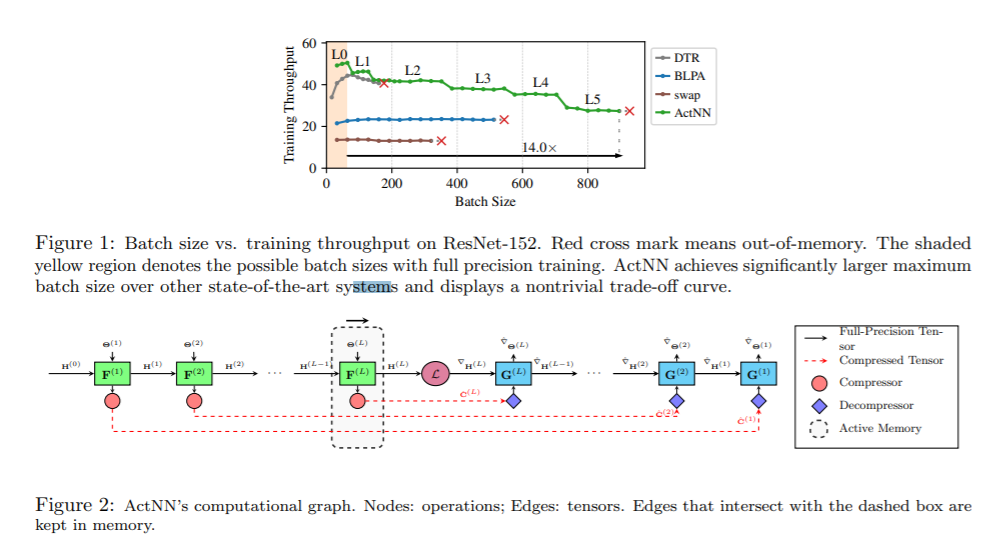

简介:神经网络模型规模的增加对于提高其准确性至关重要,但设备内存没有以相同的速度增长。这给训练神经网络带来了根本性的挑战有限内存环境中的网络。在这项工作中,我们提出了ActNN,一种内存高效的存储用于反向传播的随机量化激活的训练框架。我们证明用于一般网络架构的ActNN收敛,我们描述了量化的影响通过梯度方差的精确表达式进行收敛。使用我们的理论,我们提出新的混合精度量化策略,利用激活跨特征的异质性维度、样本和层。这些技术可以很容易地应用于现有的动态图框架,例如PyTorch,只需替换层即可。我们在主流上评估 ActNN用于分类、检测和分割任务的计算机视觉模型。在所有这些任务中,ActNN将激活平均压缩到 2 位,精度损失可以忽略不计。ActNN减少内存激活的足迹增加了 12 倍,并且能够以 6.6 倍到 14 倍的批量大小进行训练。

论文下载:https://arxiv.org/pdf/2104.14129.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢