【论文标题】 Learning Structured Sparsity in Deep Neural Networks

【作者团队】Wei Wen,Chunpeng Wu,Yandan Wang,Yiran Chen,Hai Li

【发表时间】NIPS 2016

【机构】匹兹堡大学

【论文地址】https://arxiv.org/pdf/1608.03665

【代码地址】https://github.com/wenwei202/caffe.git

【推荐理由】

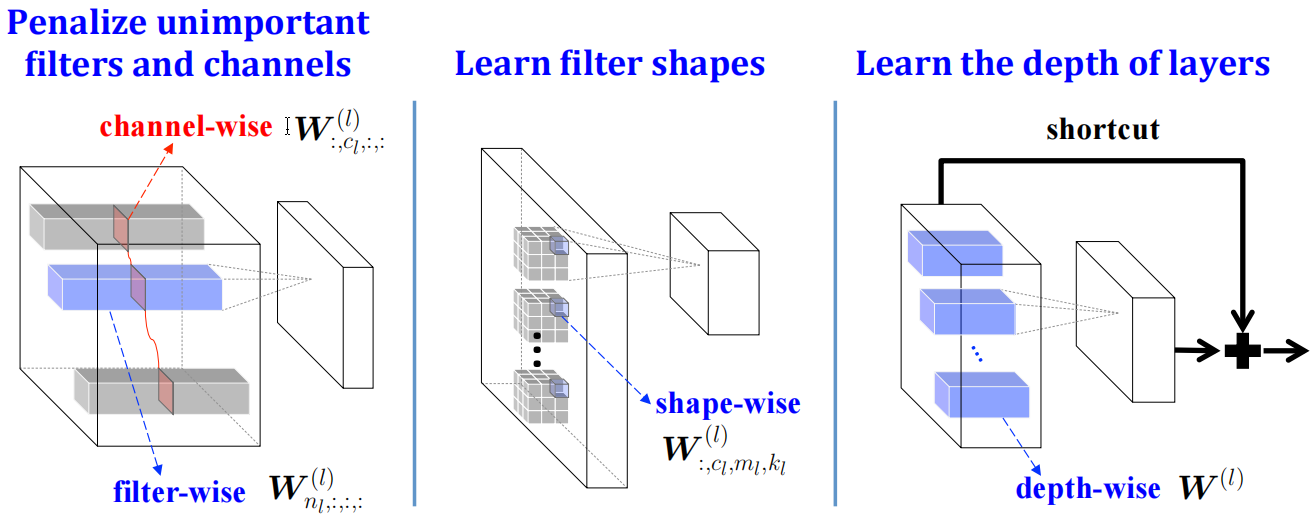

图. DNNs结构化稀疏学习 (SSL) 方法

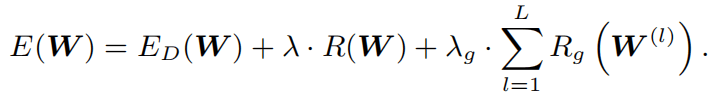

在资源受限设备中部署大规模深度神经网络 (DNN)面临诸多挑战。在论文中,作者提出了一种结构化稀疏学习 (SSL) 方法来“规范化” DNN 的结构(即过滤器、通道、滤波器形状和网络层深度)。由公式

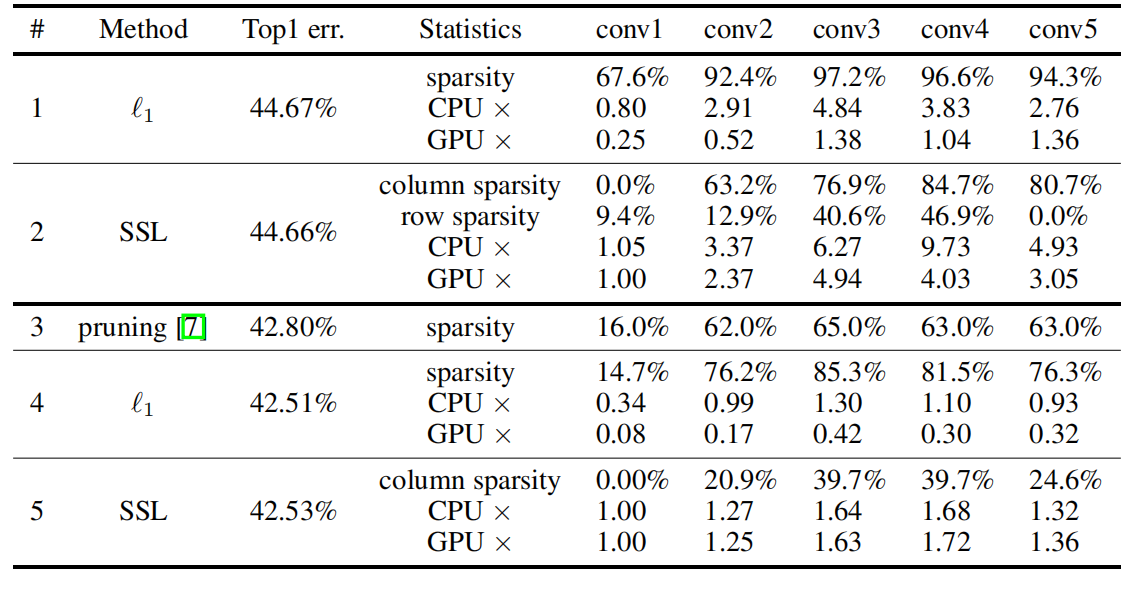

可知,这些学习到的“结构”是通过拆分 w(g) 组的方式决定的,即通过指定图中的过滤器、通道、形状和网络层深度稀疏性,可以惩罚不重要的过滤器和通道,学习任意形状的过滤器并正则化网络层深度。 该方法可以:(1)从更大的 DNN 中学习紧凑的结构以降低计算成本; (2) 获得硬件友好的 DNN 结构化稀疏性,以有效加速 DNN 推理。实验结果表明,使用现成的库SSL 分别实现了 AlexNet 对 CPU 和 GPU 的卷积层计算平均 5.1 倍和 3.1 倍的加速,大约是非结构化稀疏方法的两倍; (3)正则化DNN结构,提高分类精度。实验结果表明,对于 CIFAR-10,层深度的正则化将 20 层的深度残差网络(ResNet)减少到 18 层,同时将准确率从 91.25% 提高到 92.60%,仍然高于原始的 32 层 ResNet .对于 AlexNet,SSL 将错误降低了大约 1%。

可知,这些学习到的“结构”是通过拆分 w(g) 组的方式决定的,即通过指定图中的过滤器、通道、形状和网络层深度稀疏性,可以惩罚不重要的过滤器和通道,学习任意形状的过滤器并正则化网络层深度。 该方法可以:(1)从更大的 DNN 中学习紧凑的结构以降低计算成本; (2) 获得硬件友好的 DNN 结构化稀疏性,以有效加速 DNN 推理。实验结果表明,使用现成的库SSL 分别实现了 AlexNet 对 CPU 和 GPU 的卷积层计算平均 5.1 倍和 3.1 倍的加速,大约是非结构化稀疏方法的两倍; (3)正则化DNN结构,提高分类精度。实验结果表明,对于 CIFAR-10,层深度的正则化将 20 层的深度残差网络(ResNet)减少到 18 层,同时将准确率从 91.25% 提高到 92.60%,仍然高于原始的 32 层 ResNet .对于 AlexNet,SSL 将错误降低了大约 1%。

表. ILSVRC 2012数据集上AlexNet 的稀疏性和加速性能对比

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢