【论文标题】FLEX: Unifying Evaluation for Few-Shot NLP

【作者团队】Jonathan Bragg, Arman Cohan, Kyle Lo, Iz Beltagy

【发表时间】2021/07/15

【机 构】艾伦人工智能研究院

【论文链接】https://arxiv.org/pdf/2107.07170v1.pdf

【代码链接】https://github.com/allenai/flex

本文提出了理想的小样本NLP基准的要求,并提出了FLEX,这是第一个为小样本NLP技术提供统一、全面测量的基准、公共排行榜和框架。FLEX结合并引入了新的小样本评估,包括对四种迁移设置的度量,零样本评估的标签等。此外本文提出了UniFew,一个简单而强大的基于提示的小样本学习模型,它统一了预训练和微调提示格式,回避了基于提示的方法在适应下游任务格式和语言模型预训练目标时的复杂机制。本文证明,尽管UniFew很简单,但它取得了与元学习和基于提示的方法相比具有竞争力的结果。

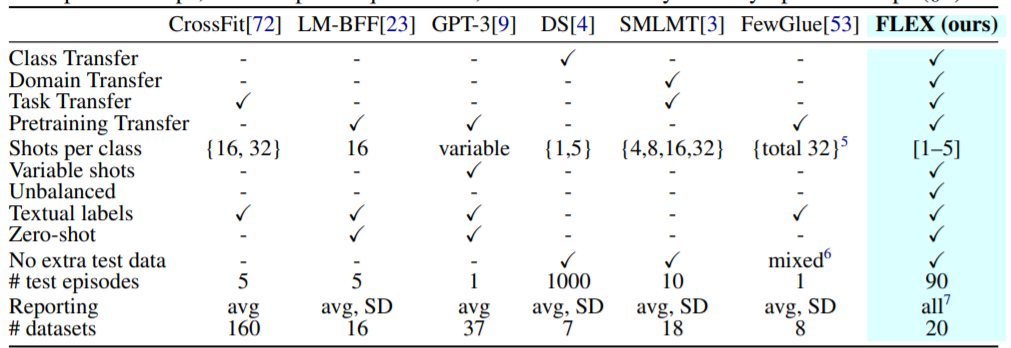

上图显示了FLEX与接近小样本工作的比较。FLEX由样本数在[1-5]范围内不固定的事件组成,且存在类不平衡性。

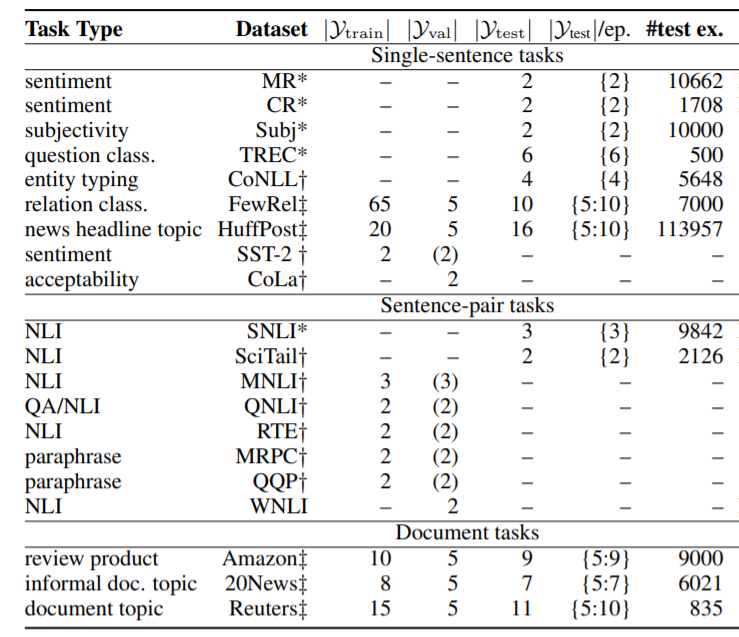

上表展示了FLEX数据集。

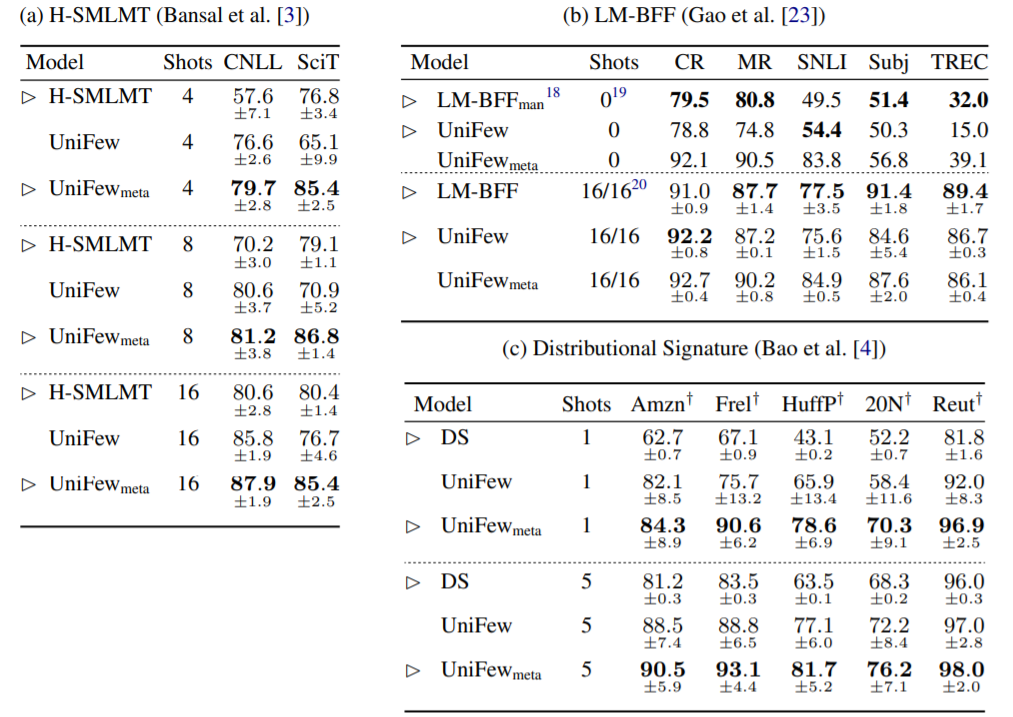

上表为UniFew与之前的方法进行比较,报告平均精度(和标准偏差)。对于每个结果集,对于相同数量的镜头,当结果可以直接比较时,我们用三角表示,黑体字表示两者中较好的一个。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢