CV领域一直渴望找到一种方法,让计算机和人类都能够理解室内场景的复杂性。他们已经创建了没有真实值标签的合成数据集,具有互动能力的模拟环境能够快速推动对环境的全面了解。然而,现有的综合数据集和模拟器存在一些局限性,这些局限性包括:

合成数据集可以从非公开可用的3D资产中生成,并且不包括渲染过程中使用的底层3D 资产。这些数据集的用途有限,因为它们缺乏几何学习问题所需的重要信息,如网格形式中的三角形或其他几何类型。

合成数据集通常不能在其数据中提供语义分割。这意味着这些片段可以将像素组合在一起,而不是语义上有意义的对象。它们也缺乏能够让计算机程序或人类用户理解哪些集群比另一个集群更重要的能力。

第三,大多数数据集和模拟器没有将图像分解为分离的光照和阴影部分,这使得它们不适用于反向渲染问题。没有现有的合成数据集或模拟器能够解决所有这些限制,包括那些已经开发出来以帮助更好地理解户外场景的数据集。

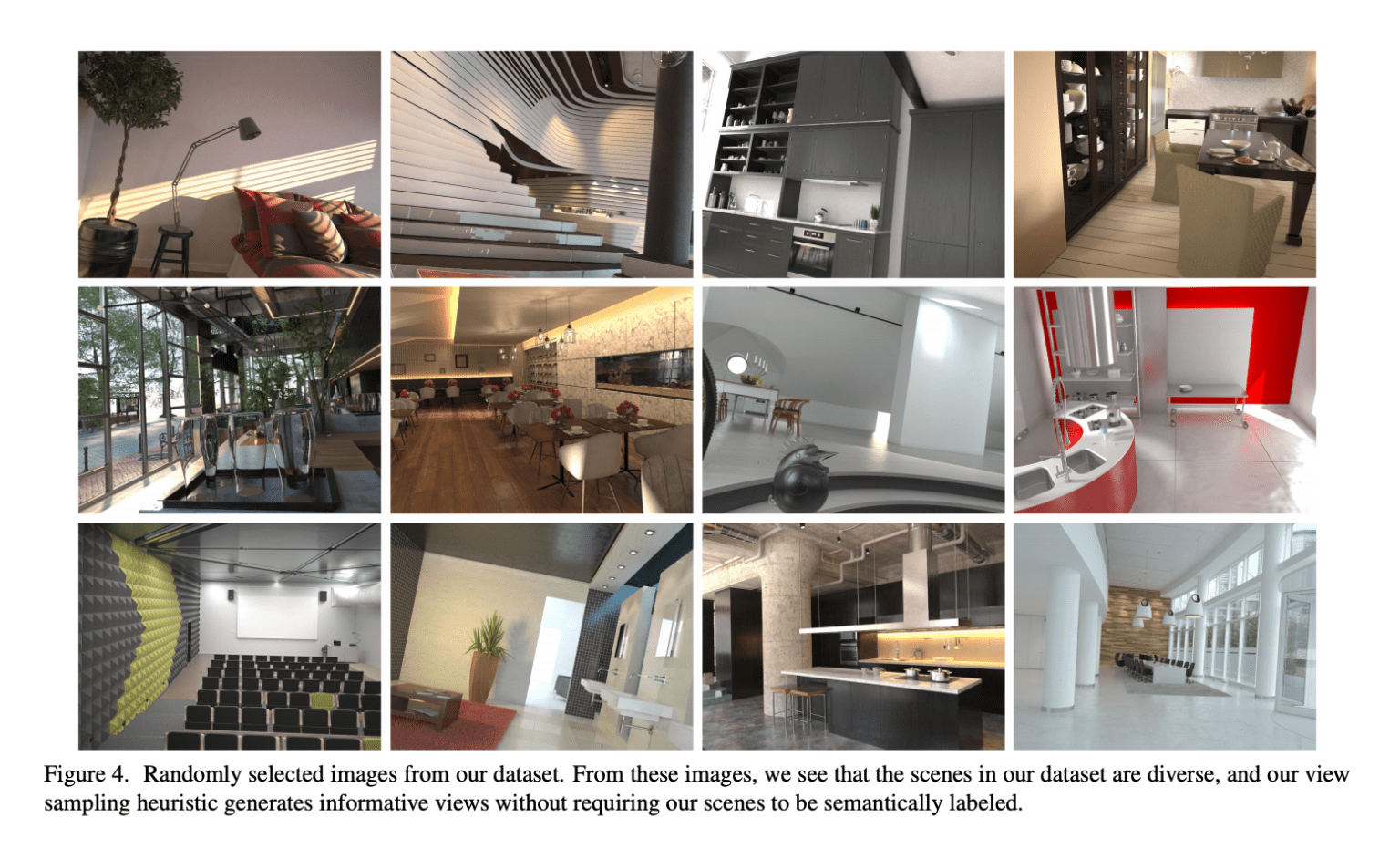

为了解决这些问题,Apple 研究人员开发了“ Hypersim”,这是一种用于整体室内场景理解的逼真合成数据集。 为了创建“ Hypersim ”数据集,苹果研究人员使用了由专业艺术家创建的大型合成场景存储库。他们生成了 461 个室内场景的 77,400 张图像,带有详细的每像素标签和相应的地面实况几何。

Hypersim 是一个可以提供高分辨率纹理和动态光照的真实三维场景的数据集。Hypersim 数据库除了对所有图像进行密集的逐像素语义实例分割之外,还包括完整的场景几何、材料信息和每幅图像的照明信息。这些特性使 Hypersim 数据集成为任何需要直接三维监控的几何学习问题,以及涉及多种输入输出模式推理的多任务问题的极好选择。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢