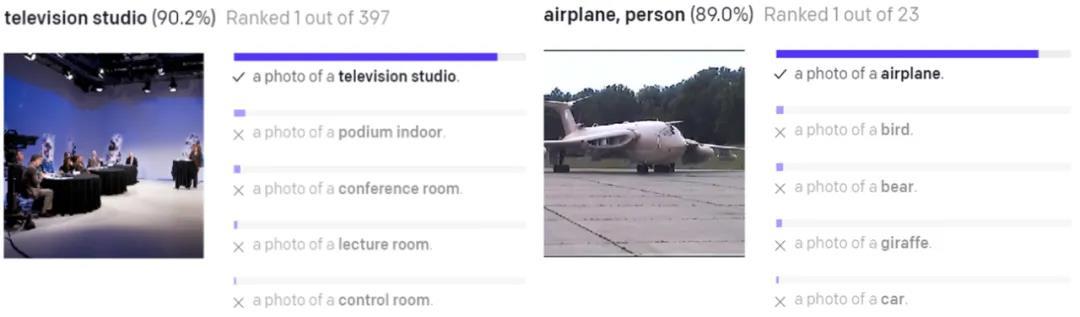

今年 1 月初,OpenAI 打破了自然语言与视觉的次元壁,接连推出了两个连接文本与图像的神经网络 DALL·E 和 CLIP,后者能够完成图像与文本类别的匹配。CLIP 能够可靠地执行一系列视觉识别任务,给出一组以语言形式表述的类别,它即能够立即将一张图像与其中某个类别进行匹配,而且不像标准神经网络那样需要针对这些类别的特定数据进行微调。

CLIP 模型的一些效果示例。图源:OpenAI

之后,OpenAI 更是在 CLIP 模型中发现了多模态神经元。这类神经元能够对以文本、符号或概念形式呈现的相同概念作出反应,例如「Spider-Man」神经元(类似 Halle Berry 神经元)能够对蜘蛛图像、文本「spider」的图像和漫画人物「蜘蛛侠」做出响应。

虽然 CLIP 模型在匹配图像与文本类别方面非常强大,但它是在 4 亿多个图像 - 文本对上训练的,使用了很大的算力,需要 256 个 GPU 训练两周。这对于普通开发者来说是无法想象的。因此,是否有可能缩小 CLIP 模型的尺寸,并且不减弱其性能呢?

最近,PicCollage 公司的研究者对这一课题展开了研究,他们在自己的内容产品上对 CLIP 模型的性能进行了测试,并且获得了满意的效果。不过很快发现了 CLIP 模型的一个奇怪点:在搜索查询中优先考虑文本相似度而不是语义相似度。他们想要解决 CLIP 模型过分重视文本相似度的问题,以此获得更相关的搜索结果。

除此之外,研究者还想缩小 CLIP 模型的尺寸并探索在 IOS 设备上部署的可能性。他们使用模型蒸馏的方法来缩小 CLIP 的尺寸,350MB 的原始模型(可称为 teacher 模型)蒸馏后降为 48MB(student 模型),精度为 FP32。并且,在单个 P100 GPU 上训练了数周后,他们将 48MB 大小的 student 模型转换成了 CoreML 格式,并再次得到了 24MB 大小的模型,精度为 FP16,性能变化几乎可以忽略不计。研究者表示,蒸馏后的模型可以在 iPhone 等 IOS 设备上运行。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢