特斯拉举办了他们的人工智能日,揭示了他们的软件和硬件基础设施的内部运作。这次披露的一部分是之前预告的Dojo人工智能训练芯片。特斯拉声称他们的D1 Dojo芯片具有GPU级别的计算能力,CPU级别的灵活性,以及网络开关IO。几周前,我们猜测这个系统的封装是台积电的晶圆上集成扇出系统(InFO_SoW)。我们解释了这种类型的封装的好处,以及这种大规模培训芯片所涉及的冷却和功耗。此外,我们估计这种封装在性能上将超过Nvidia系统。所有这些似乎都是基于披露的有效猜测。今天,我们将更深入地研究揭示的半导体的具体细节。

先让我们谈谈评估基础设施。特斯拉不断重新训练和改进他们的神经网络。他们评估任何代码变化,看看是否有改进。有数以千计的相同芯片被部署在汽车和服务器中。他们每周运行数百万次的评估。

特斯拉多年来一直在扩大其GPU集群的规模。如果特斯拉停止所有的实际工作负载,运行Linpack,并提交给Top500名单,他们目前的训练集群将成为第五大超级计算机。这种性能的扩展对于特斯拉和他们的野心来说是不够的,所以他们在几年前就开始着手开发自己的芯片,即Dojo项目。特斯拉需要更多的性能来实现更大、更复杂的神经网络,并以高效、低成本的方式。

特斯拉的架构解决方案是一个分布式计算架构。当我们听了他们的细节后,这个架构似乎与Cerberus非常相似。我们在这里分析了Cerebras Wafer Scale Engine和它的架构。每一个人工智能训练架构都是这样布局的,但计算元素、网络和结构的细节差别很大。这些类型的网络的最大问题是扩大带宽和保留低延迟。为了扩展到更大的网络,特斯拉特别关注这后两者。这影响了他们从芯片结构到包装的每一部分设计。

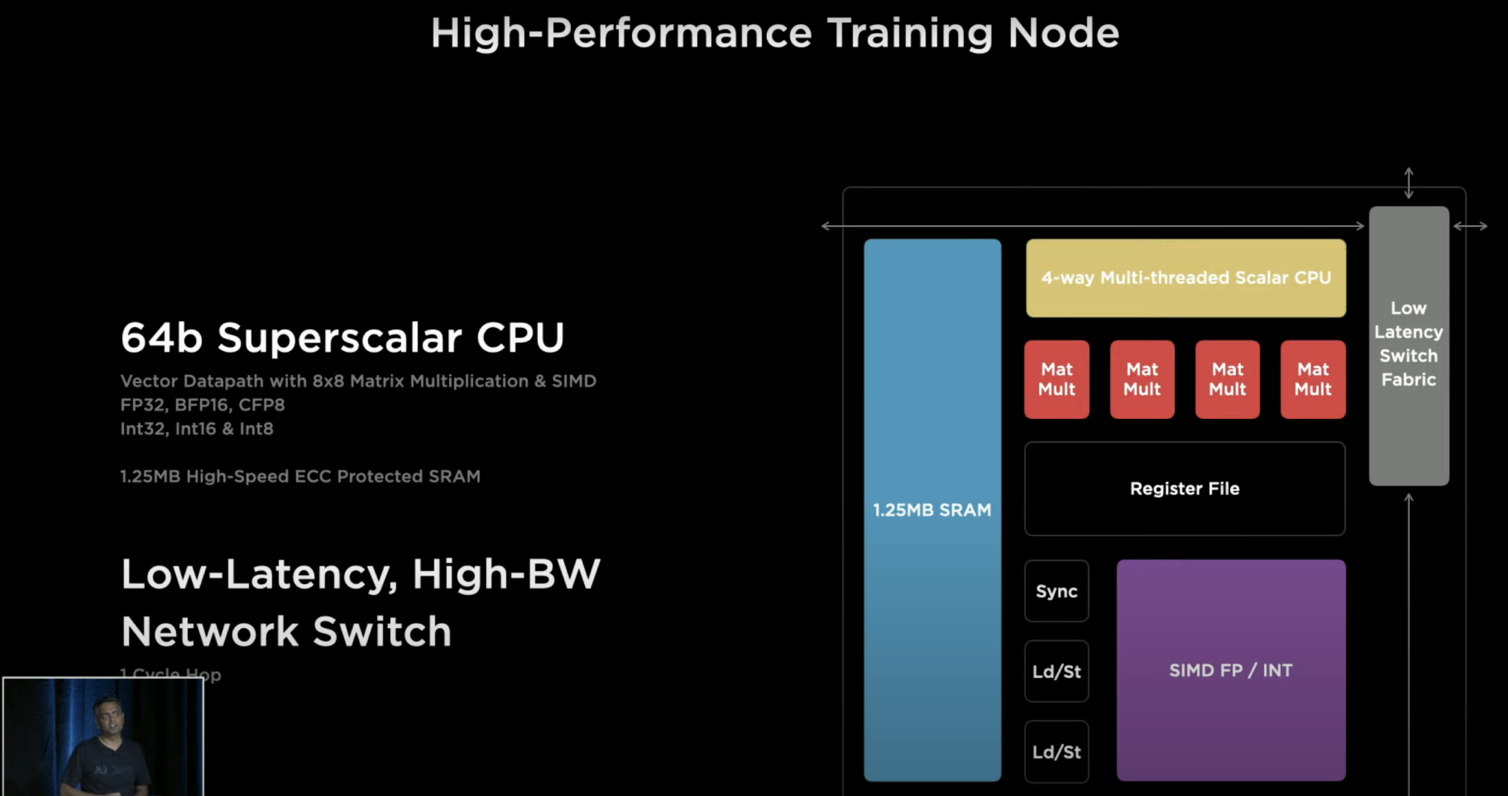

功能单元被设计成可在1个时钟周期内穿越,但又足够大,以至于同步开销和软件不会成为问题的主导。因此,他们得出的设计几乎与Cerebras完全一样。一个由高速结构连接的单个单元组成的网状结构,在1个时钟内完成功能单元之间的通信路由。每个独立单元都有一个大的1.25MB的SRAM刮板和多个具有SIMD功能的超标量CPU内核,以及支持所有常见数据类型的矩阵乘法单元。此外,它们还引入了一种名为CFP8的新数据类型,即可配置浮点8。每个单元能够实现1TFlop的BF16或CFP8,64GFlops的FP32,以及每个方向512GB/s的带宽。

CPU也不是省油的灯,它在矢量管道上有4个宽,2个宽。每个核心可以承载4个线程,以最大限度地提高利用率。不幸的是,特斯拉采用了定制的ISA,而不是建立在RISC V这样的开源ISA之上。这个定制的ISA引入了转置、收集、广播和链接遍历的指令。

这354个功能单元的完整芯片达到BF16或CFP8的362TFlops和FP32的22.6TFlops。它总共有645mm^2和500亿个晶体管。每个芯片的TDP达到了令人惊叹的400W。这意味着功率密度高于Nvidia A100 GPU的大多数配置。有趣的是,特斯拉实现了每毫米^2的有效晶体管密度为7750万个晶体管。这比其他所有的高性能芯片都要高,仅被移动芯片和苹果M1击败。

基本功能单元的另一个有趣方面是NOC路由器。它以一种与Tenstorrent非常相似的方式在芯片内部和芯片之间进行扩展。链接是我们对该架构的分析。特斯拉与其他知名的人工智能初创公司达成类似的架构,这并不奇怪。Tenstorrent非常注重规模化训练,而特斯拉也在大力关注这方面的问题。

在芯片上,特斯拉拥有令人惊叹的10TBps定向带宽,但这个数字在实际工作负载中意义不大。与Tenstorrent相比,Tesla的一个巨大优势是芯片之间的带宽明显更高。他们有576个SerDes,112GTs。这产生了64Tb/s或8TB/s的总带宽。

我们不确定特斯拉从哪里得到他们所说的每个边缘的4TB/s,它更可能是X轴上的数字和Y轴上的数字。不要介意这个令人困惑的幻灯片,这个芯片的带宽是疯狂的。目前已知的最高外部带宽芯片是32Tb/s的网络交换芯片。特斯拉能够通过大量的SerDes和先进的封装将其翻倍。

Tesla将Dojo芯片的计算平面与接口处理器连接起来,接口处理器通过PCIe 4.0连接到主机系统。这些接口处理器还能实现更高的径向网络连接,补充现有的计算平面网状结构。

25个D1芯片被包装成 "扇出式晶圆工艺",称为训练瓦片。特斯拉没有确认这种封装是台积电的晶圆上集成扇出系统(InFO_SoW),就像我们几周前猜测的那样,但考虑到疯狂的芯片间带宽和他们特别说的扇出晶圆的事实,似乎极有可能。

特斯拉开发了一种专有的高带宽连接器,保留了这些瓦片之间的片外带宽。每块瓦片都有令人印象深刻的9 PFlops的BF16/CFP8和36 TB/s的片外带宽。这远远超过了Cerebras的片外带宽,并使特斯拉系统的扩展能力甚至超过了Tenstorrent架构等扩展设计。

电力输送是独特的、定制的,也是极其令人印象深刻的。由于有这么多的带宽和超过10KW的功耗,特斯拉在电源传输方面进行了创新,并垂直输送。 定制的电压调节器被直接回流到扇出的晶圆上。电源、热能和机械都是直接与瓦片对接。

即使芯片本身的总功率只有10KW,看起来整个瓦片的功率也有15KW。电源传输、IO和晶圆线也在消耗大量的电力。功率从底部进入,而热量则从顶部出来。芯片不是特斯拉的规模单位,25个芯片的瓦片才是。这块芯片在单位性能和扩展能力方面远远超过了Nvidia、Graphcore、Cerebras、Groq、Tenstorrent、SambaNova或任何其他面向人工智能培训的初创公司。

所有这些似乎都是遥远的技术,但特斯拉声称他们已经在实验室中的真实人工智能网络上以2GHz的速度运行瓷砖。

扩展到数千个芯片的下一步是服务器级别。Dojo被扩展到2乘3的瓦片配置,一个服务器机柜里有两个这样的配置。对于那些在家计算的人来说,每个机柜总共有12个瓦片,每个机柜总共有108 PFlops。每个服务器机柜有超过10万个功能单元、40万个定制内核和132GB的SRAM,这是令人震惊的数字。

特斯拉在他们的网状结构中,不断地将规模进一步扩大到机柜级。芯片之间的带宽没有细分。这是一个由芯片组成的同质网,具有疯狂的带宽。他们计划将规模扩大到10个机柜和1.1 Exaflops。1,062,000个功能单元,4,248,000个内核,1.33TB的SRAM。

软件方面很有趣,但我们今天不会太深入地研究它们。他们声称,他们可以虚拟地进行细分。他们说,无论集群大小,软件都可以在Dojo处理单元(DPU)之间无缝扩展。Dojo编译器可以照顾到细粒度的并行性,并跨硬件计算平面映射网络。它可以通过数据模型图的并行性实现这一点,但也可以进行优化以减少内存占用。

模型的并行性可以跨越芯片的界限,轻松地解锁具有数万亿参数的下一层次的人工智能模型,甚至更多。甚至不需要大的批处理量。他们不需要依靠手写的代码来在这个大规模的集群上运行模型。

把这一切联系起来,与Nvidia GPU的成本相当,Tesla声称他们可以实现4倍的性能,每瓦1.3倍的性能,以及5倍的占地面积。特斯拉的总拥有成本优势比Nvidia的人工智能解决方案好近一个数量级。如果他们的说法是真的,特斯拉已经在人工智能硬件和软件领域超越了所有人。我持怀疑态度,但这也是一个硬件怪胎的梦想。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢