标题:清华、微软|Fastformer: Additive Attention is All You Need(Fastformer:加法注意力就是你所需要的)

推荐理由:变换器的一种全新且具有广泛应用前景的变种

作者:清华大学信息认知和智能系统研究所Chuhan Wu、黄永峰教授

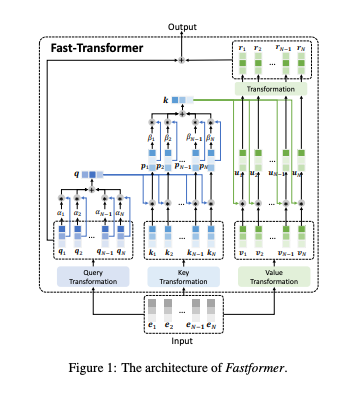

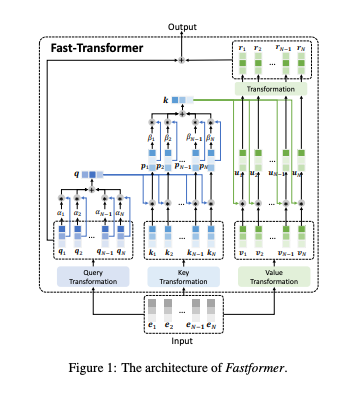

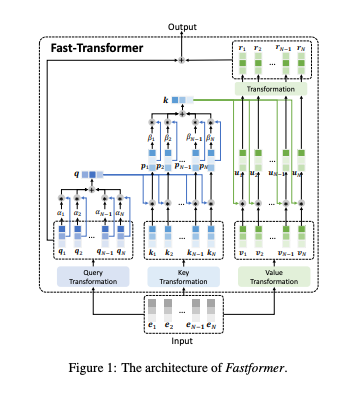

简介:变换器是一种强大的文本理解模型。 但是由于效率低下输入序列长度的二次复杂度,虽然方法很多变换器加速,他们还是在长序列条件下效率低下。在本文中,我们提出了Fastformer,这是一个基于高效变换器模型的加法注意力。在Fastformer中,对成对相互作用字符建模,我们首先使用加法注意力机制来建模全局上下文,然后进一步转换基于每个符号表示与全局上下文表示的交互。 这样,Fastformer就可以实现线性复杂度的有效上下文建模。对五个数据集的广泛实验表明,Fastformer比许多现有的变换器模型效率更高,同时可以达到可比甚至更好的长文本建模性能。

下载地址:https://arxiv.org/pdf/2108.09084v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢