近日,天津大学智能与计算学部天津市先进网络技术与应用重点实验室(Tanklab)刘秀龙教授和李克秋教授指导投稿的论文《RFID and Camera Fusion for Recognition of Human-object Interactions》被网络系统领域顶级会议International Conference on Mobile Computing and Networking (ACM MobiCom 2021) 录用。

该会议由ACM SIGMOBILE赞助,致力于解决网络通信和移动计算方向的挑战性难题。MobiCom有非常严格的审稿过程:每篇论文在接收前要经过2轮双盲评审,并在程序委员会再次盲审讨论后考虑有条件录用;作者须根据所有审稿意见进行论文修改,通过程序委员会一致同意后才正式录用论文。ACM MobiCom的论文录取率通常在15%左右,2021年全球仅录取59篇。

论文介绍

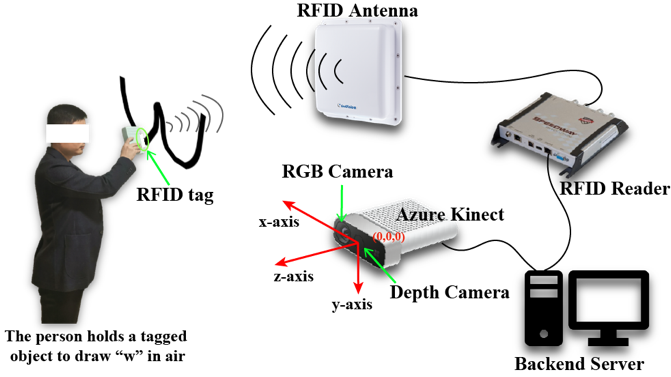

物联网、大数据和人工智能的快速发展开启了人-机-物深度融合时代,本研究聚焦人-物交互识别问题,在未来许多场景具有应用价值。例如:在商场中,顾客通过拿起商品在空中挥动特定手势,便可实现信息查询、商品推荐;在工厂中,员工发现零件损坏,可以拿起该零件绘制特定手势,高效通知后台安排维修;在家庭中,用户可以从冰箱里取出食物,通过特定手势查询保质期或食谱。这些应用背后最关键的技术就是识别人-物交互动作。为此,该论文首次研究多人、多物场景下基于手势的人-物交互识别,并设计实现了RF-Camera系统(图1展示了系统使用的设备和使用示例)。

图1 RF-Camera 设备部署图

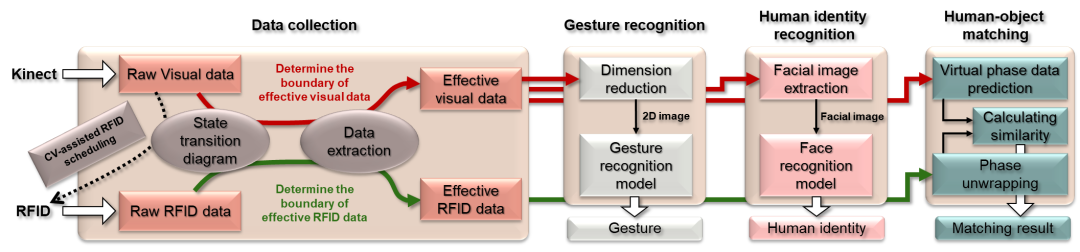

系统融合了射频识别(RFID) 和计算机视觉(CV)技术,能够在多人、多物场景下精确、快速识别 “谁拿了什么物品,做了什么行为”。如图2所示,其基本工作原理如下:首先,提出数据降维方法,将深度摄像头捕捉到的3D手势轨迹转化为2D图片,输入到设计的AI模型中识别手势动作;其次,基于状态转换图,识别多人场景下的目标人物,从原始RGB图像(可能包含多人的面部信息)中有效提取目标人脸子图,进而输入到AI人脸分类器中识别目标人物的身份信息;最后,基于CV技术捕捉到的手势轨迹模拟RFID标签数据,并和所有标签数据计算欧式距离,从而获得人与物的匹配映射。

图2 RF-Camera 系统概述图

在实现上述基本想法的过程中,作者解决了三个关键技术挑战:

● 为了从原始感知数据中剔除由不相关手势动作引入的噪声数据,作者提出了状态转换图刻画手势动作,从而来确定有效数据边界。

● 为了在未知“手部-标签”偏移量的情况下预测标签相位数据,作者将“手部-标签”向量作为变量加到捕获的手部3D轨迹来模拟目标标签轨迹,进而预测标签相位数据。

● 为了确保标签密集场景中目标标签仍然具有高读取率,作者提出了一种 CV 辅助 RFID 调度方法,其中对 CV 数据的分析可以帮助调度 RFID标签的通信。

作者在不同条件下进行了大量实验,结果表明在行为识别,身份识别和人-物匹配方面的平均准确率均在90%以上。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢