近期,由于图结构数据在现实生活中存在的广泛性与普遍性(例如,在推荐系统中可以用图来表示用户与商品之间的交互、在化学中可以用图来建模分子等等),引起了研究者对将深度学习应用到,推动了图领域的相关研究蓬勃发展。深度学习发展成功的一个主要因素在于模型的深层次架构。然而,图神经网络模型随模型深度增加性能却会较快下降。一种主流研究认为,GNN模型做不深的原因在于过平滑 - 即图卷积网络有赋予相邻节点接近的表示的特点。因此,当图卷积网络的层数无限加深时,所有节点的表征都倾向收敛于同一个点。

本篇工作探讨了为什么图神经网络模型做不深的原因,通过实验的方式对于主流的研究观点进行验证与探讨,并提出我们认为的GNN模型普遍较浅的真正原因 - 模型退化与过平滑。

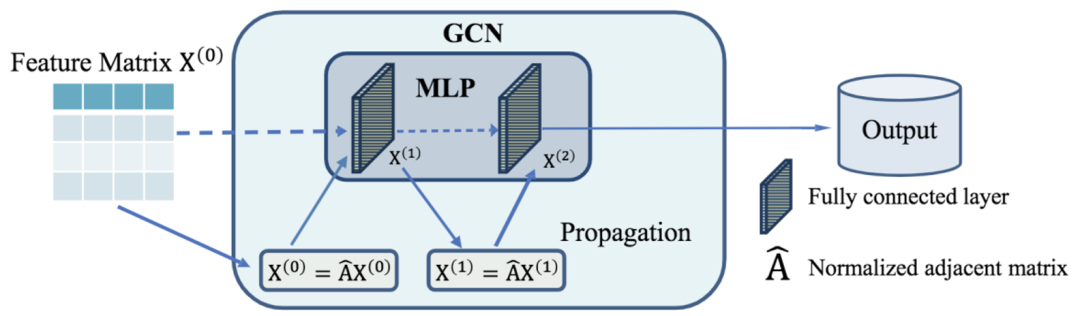

首先我们对图卷积模型的图卷积层进行分析。在图卷积层中,主要包含两个操作:特征传播(propagate)操作和非线性变换(Transformation)操作。因此,图神经网络的模型相应地也应该分为两个深度,特征传播的深度 和非线性变换的深度

。我们在图1中展示图卷积网络的两个操作。如图1所示,特征传播可以用

表示,而非线性变换可以理解为一层简单的MLP中的dense layer。从图中我们可以看到,图卷积层与MLP最大的区别在于图卷积层多了一层特征传播的过程。如果我们把邻接矩阵替换为单位矩阵,图卷积层将退化为简单的MLP层。经过对现有deep GNN的相关工作的分析,我们发现,绝大多数工作只关注到了特征传播

的深度,而忽略了非线性变换

的深度。

图1. GCN与MLP的关系示意图

我们对现有研究深层GNN的工作进行了详细的分析,并对它们提出的关于GNN无法做深的原因进行了实验的验证和探究。

基于分析,得到如下的结论:

- GNN模型通常有两个深度,分别是特征传播深度

和非线性变换深度

;

和

增大会分别带来过平滑和模型退化的问题.并且模型退化通常在深层GNN性能下降的问题中占主导地位;

- Skip-connection可以有效减轻模型退化问题;

- 大多数解耦的GNN虽然能做深,但增加的只是特征变换的深度

。

详细分析可以参考论文原文。

论文:Zhang W, Sheng Z, Jiang Y, et al. Evaluating Deep Graph Neural Networks. arXiv preprint arXiv:2108.00955, 2021.

论文地址:https://arxiv.org/abs/2108.00955

论文代码:https://github.com/zwt233/DGMLP

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢