论文链接:https://arXiv.org/abs/2108.13002

本文是中科大&MSRA在DNN的CNN、Transformer以及MLP三大流派纷争方面的一点深入思考。为分析不同架构的特性,作者首先构建了一个统一架构SPACH将Mixing做成可配置型,以此为基础上CNN、Transformer以及MLP进行挖掘得出:多阶段优于单阶段、局部建模非常重要以及CNN与Transformer的互补性。基于所挖掘特性构建了一种CNN与Transformer混合模型,所得模型仅需63M参数量即可在ImageNet数据集上取得83.9%的top1精度,优于Swin-B、CaiT-S36。

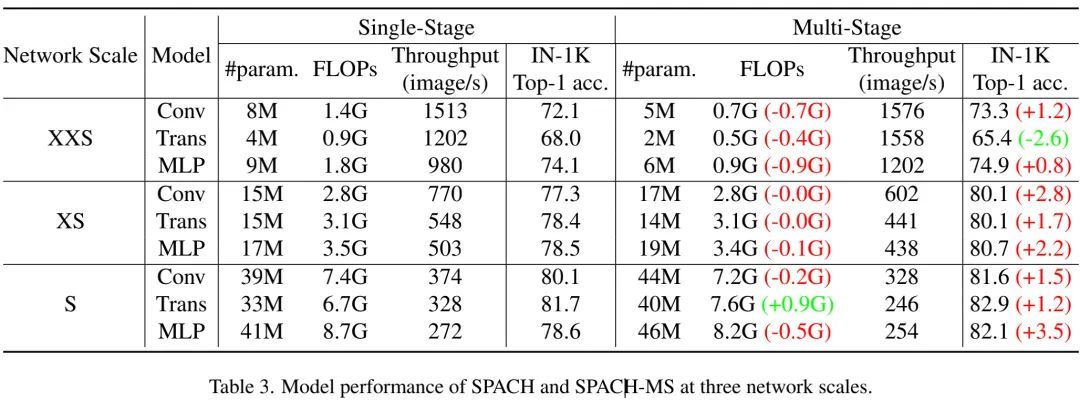

下表比较了单阶段与多阶段SPACH模型在ImageNet分类任务上的性能对比,从中可以看到:对于三种大小网络、三种类型网络架构,多阶段网络均取得了比单阶段网络更佳的复杂度-精度均衡 。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢