标题:里斯本大学 、Deep Mind|∞-former: Infinite Memory Transformer(Infinite-former:无限记忆变换器)

作者:Pedro Henrique Martins、 Zita MarinhoÁç、André F. T. Martins

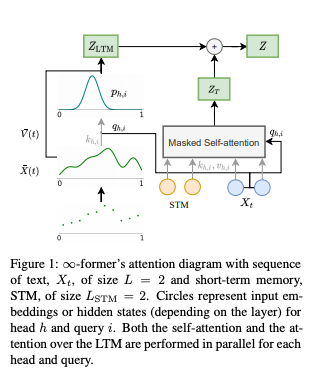

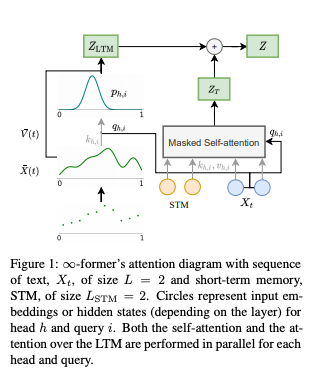

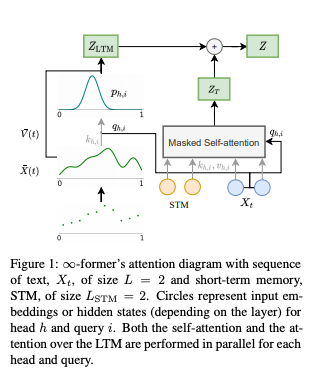

简介:变换器在长时间在上下文中挣扎,因为随着上下文长度计算量在增长,他们不能有效地模拟长期记忆。为了缓解这个问题,已经提出的几种变体都有一个有限的内存容量,被迫舍弃旧信息。在本文中,我们提出无穷变换器,它扩展了具有无限长期记忆的普通变换器。通过利用长期参与在记忆中连续空间注意力机制,Infinite-former的注意力复杂度变得独立于上下文长度。因此,它能够对任意长的上下文进行建模并保持“粘性记忆”,同时保持固定的计算量。合成排序任务的实验证明Infinite-former保留来自长序列的信息的能力。作者还通过训练对语言建模进行实验从头开始构建模型并通过微调预训练的语言模型,这显示出无限的长期记忆优势。

论文下载:https://arxiv.org/pdf/2109.00301v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢