论文标题: HumanNeRF: Free-viewpoint Rendering of Moving People from Monocular Video

论文链接:https://arxiv.org/abs/2201.04127

主页链接:https://grail.cs.washington.edu/projects/humannerf/

作者单位:华盛顿大学 & Google研究院

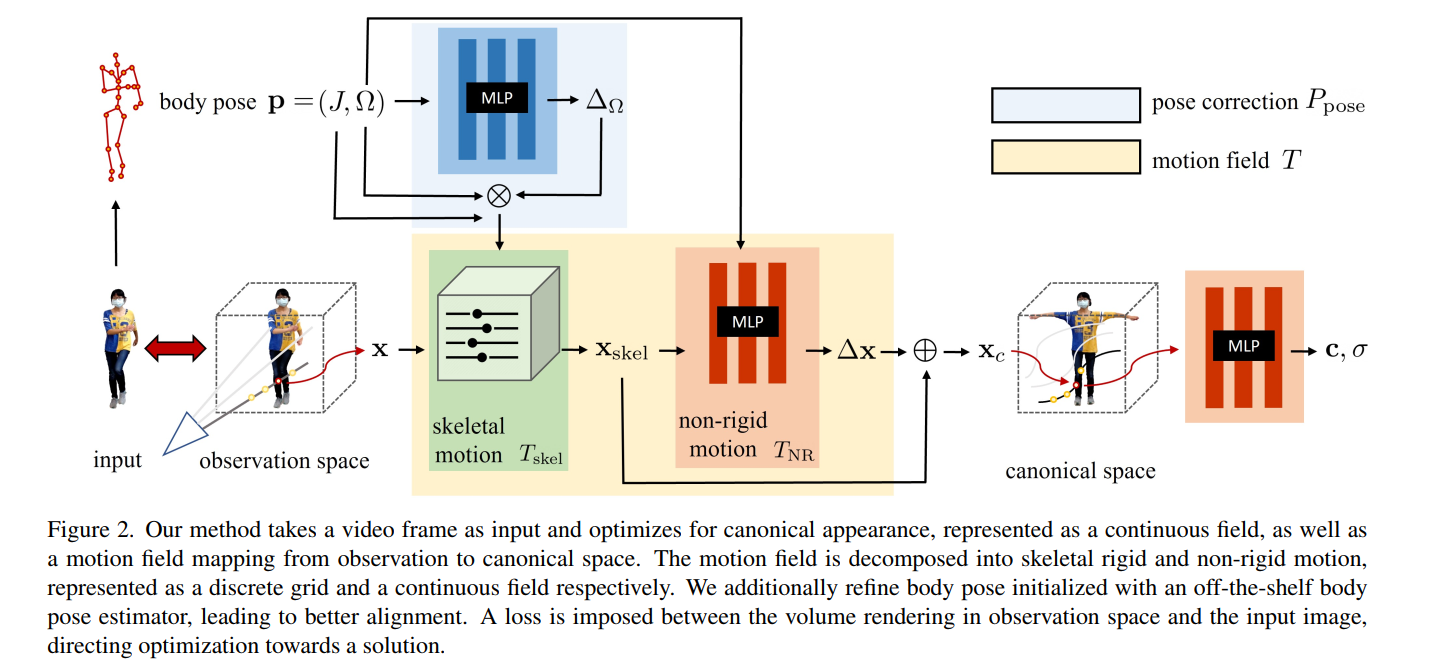

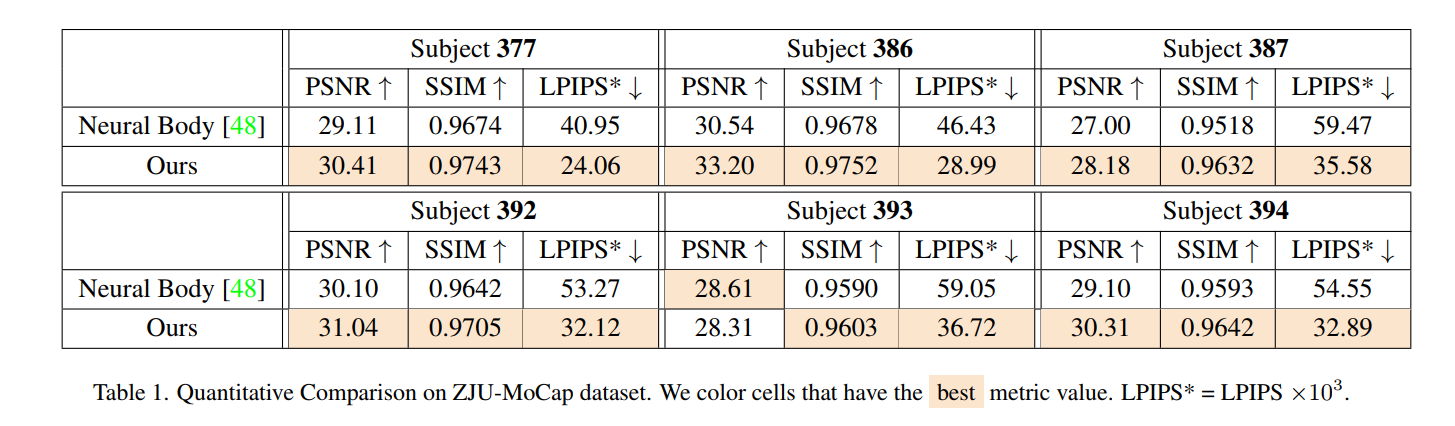

我们引入了一种自由视点渲染方法——HumanNeRF——它适用于人类执行复杂身体运动的给定单目视频,例如:来自 YouTube 的视频。我们的方法可以在任何帧暂停视频,并从任意新的摄像机视点甚至是该特定帧和身体姿势的完整 360 度摄像机路径渲染主体。这项任务特别具有挑战性,因为它需要合成身体的逼真细节,从输入视频中可能不存在的各种摄像机角度看,以及合成精细的细节,如布料褶皱和面部外观。我们的方法优化了典型 T 姿势中人的体积表示,与运动场相一致,该运动场通过向后扭曲将估计的规范表示映射到视频的每一帧。运动场被分解为由深度网络产生的骨骼刚性和非刚性运动。我们展示了与先前工作相比的显着性能改进,以及在具有挑战性的不受控制的捕获场景中移动人类的单目视频的自由视点渲染示例。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢