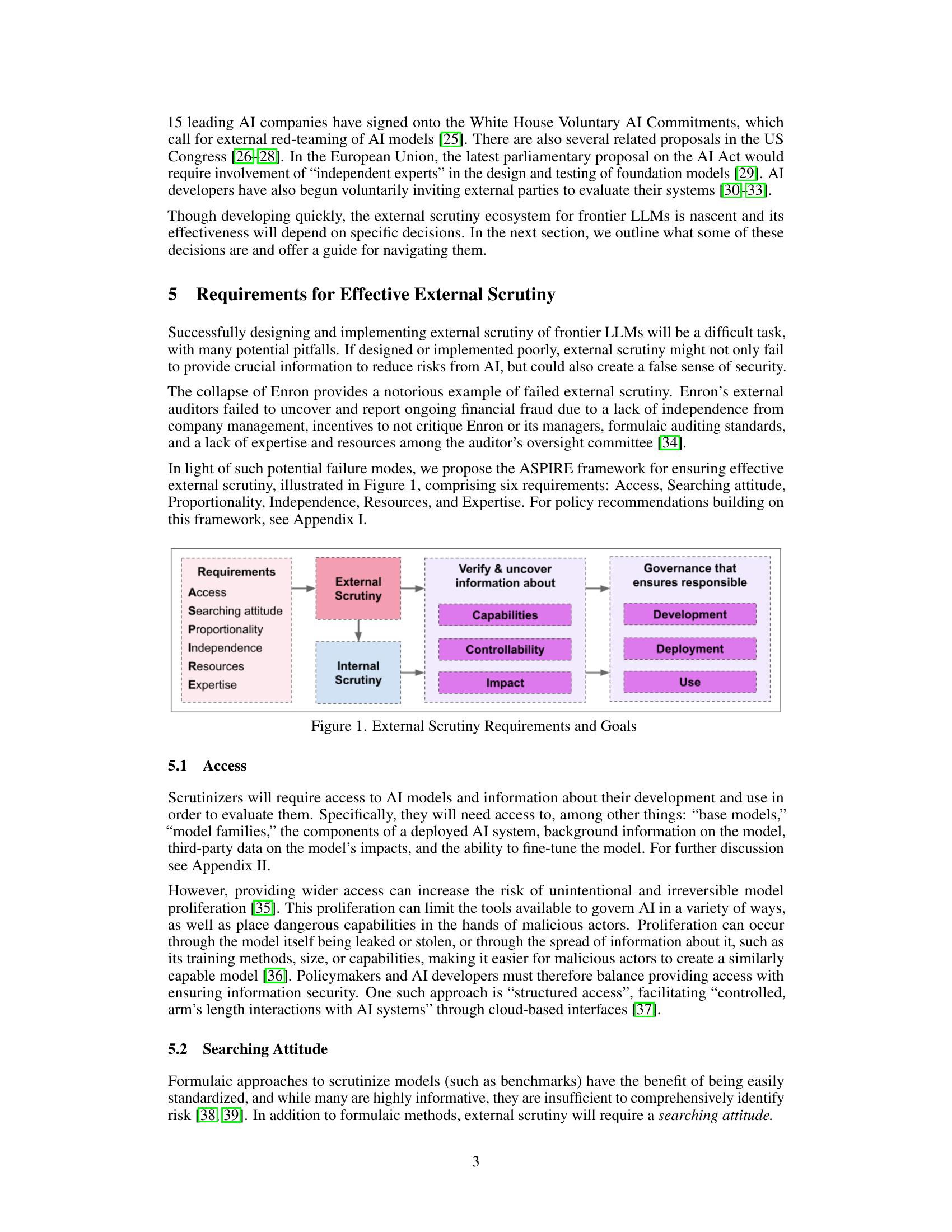

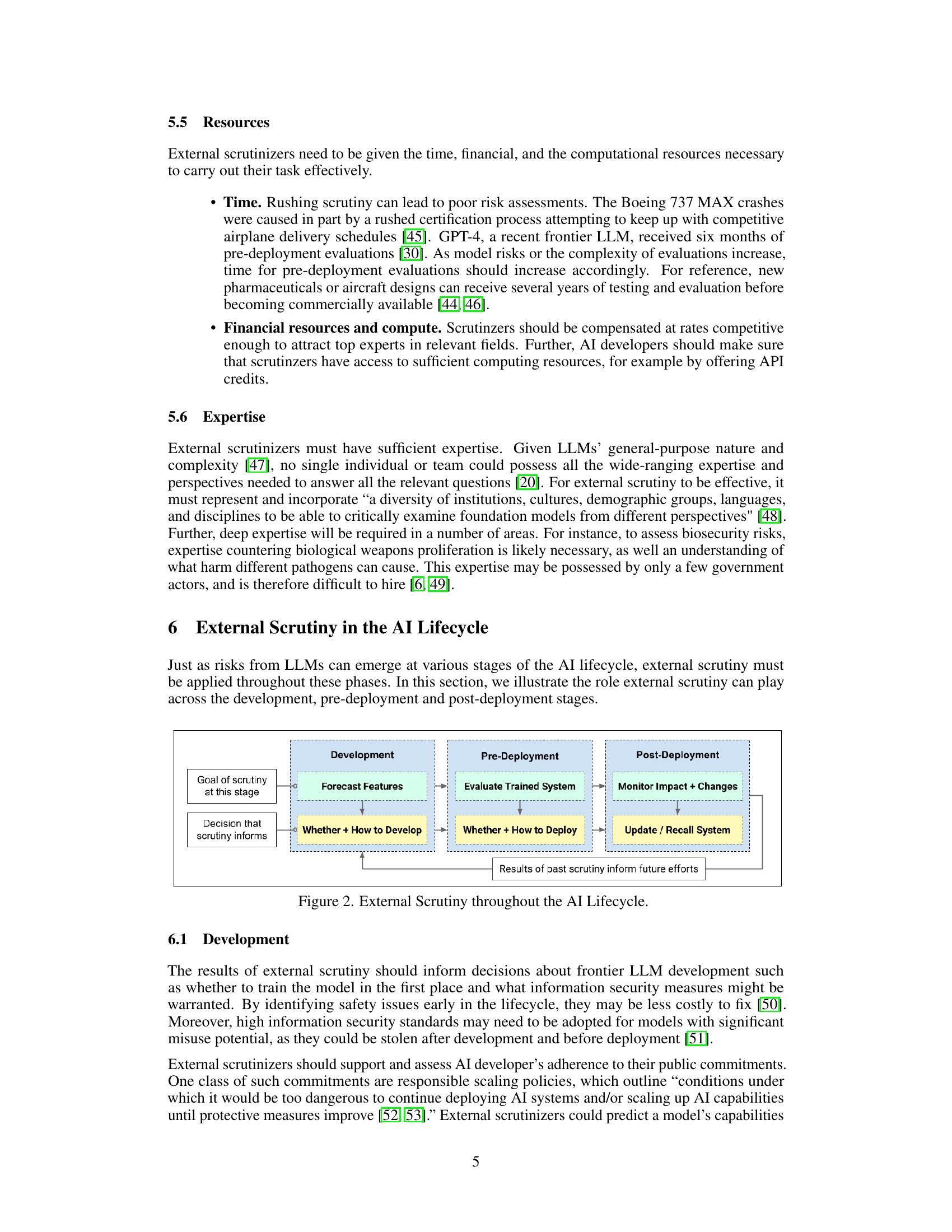

- 简介随着前沿大型语言模型(LLMs)越来越多地融入社会和经济,与它们的训练、部署和使用相关的决策具有深远的影响。这些决策不应仅由前沿LLM开发人员决定。LLM用户、公民社会和政策制定者需要可信赖的信息来源,以更好地引导这些决策。通过红队测试、审计和外部研究人员访问等方式,让外部参与者参与这些系统的评估,即我们所谓的“外部审查”,提供了一种解决方案。虽然有鼓舞人心的迹象表明,前沿LLMs的外部审查正在增加,但其成功并不确定。在本文中,我们调查了有效的前沿AI系统外部审查的六个要求,并将它们组织在ASPIRE框架下:获取、搜索态度、与风险成比例、独立性、资源和专业知识。然后,我们说明了外部审查如何在整个AI生命周期中发挥作用,并向政策制定者提出建议。

- 图表

- 解决问题如何进行有效的外部审查以提高前沿AI系统的透明度和可靠性?

- 关键思路通过ASPIRE框架提出六个要求,包括获取、寻求态度、风险相称性、独立性、资源和专业知识,以确保外部审查的有效性。

- 其它亮点论文提供了外部审查的具体应用场景和建议,并强调外部审查在提高前沿AI系统透明度和可靠性方面的重要性。

- 最近的相关研究包括对前沿大型语言模型的研究,如GPT-3等,以及对AI系统透明度和可靠性的研究。

沙发等你来抢

去评论

评论

沙发等你来抢