关于周刊:

强化学习作为人工智能领域研究热点之一,其研究进展与成果也引发了众多关注。为帮助研究与工程人员了解该领域的相关进展和资讯,智源社区结合领域内容,撰写为第44期《强化学习周刊》。本期周刊整理了强化学习领域相关的最新论文推荐等,以飨诸位。

周刊采用社区协作的模式产生,欢迎感兴趣的朋友们参与我们的工作,一起来推动强化学习社群的分享、学习和交流活动。可以扫描文末的二维码加入强化学习社区群。

本期贡献者:(李明,刘青、小胖)

关于周刊订阅:

告诉大家一个好消息,《强化学习周刊》开启“订阅功能”,以后我们会向您自动推送最新版的《强化学习周刊》。订阅方法:

方式一:

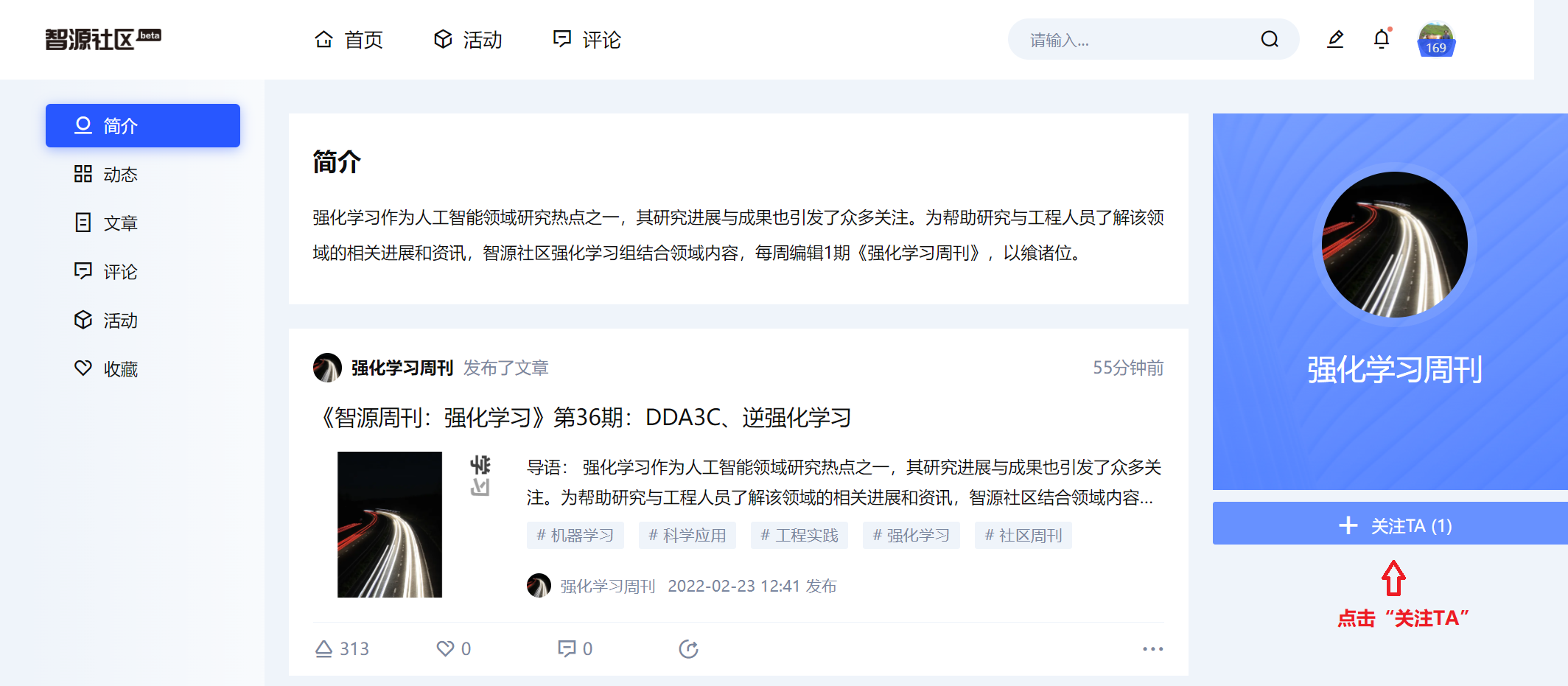

扫描下面二维码,进入《强化学习周刊》主页,选择“关注TA”。

方式二:

1,注册智源社区账号

2,点击周刊界面左上角的作者栏部分“强化学习周刊”(如下图),进入“强化学习周刊”主页。

3,点击“关注TA”(如下图)

4,您已经完成《强化学习周刊》订阅啦,以后智源社区会自动向您推送最新版的《强化学习周刊》!

背景

强化学习近年来取得了令人瞩目的成就,其应用于各个领域的研究也取得较大的进步,比如强化学习应用于策略推荐、基于深度强化学习的图像分割、量子编译及量子点电路设计、多智能体强化学习、安全强化学习相关的理论及其最新应用等。

论文推荐

本次推荐了14篇强化学习领域的相关论文,主要涉及于银行同业网络稳定性的强化学习策略推荐、面向深度强化学习多量子比特系统的高效实用量子编译器、模块化有益于强化学习智能体与竞争性稳态驱动、通过智能体生态系统提高强化学习对新环境的适应性和消除灾难性遗忘、RL-CoSeg:一种新颖的深度强化学习图像协同分割算法、基于深度强化学习的原子硅量子点电路自动设计、通过最大化基于状态动作的互信息在深度强化学习中发现不同的解决方案、基于风险的自主水面船舶COLREGs的深度强化学习实现、非线性切换系统最优控制的混合强化学习、深度强化学习调整制造业订单发布计划的平均奖励、基于偏好的奖励学习中的因果混淆研究、基于多智能体强化学习的通信学习离散化方法分析、具有时间动态对手模型的多智能体 Actor-Critic、基于黑箱可达性分析的安全强化学习等。

标题:Reinforcement Learning Policy Recommendation for Interbank Network Stability(银行同业网络稳定性的强化学习策略推荐)

简介:本文分析了策略推荐对人工银行间市场绩效的影响。金融机构根据公众推荐和个人信息制定贷款协议。前者以强化学习最优政策为模型,试图最大化系统的长期适应性,收集经济环境的信息,并指导经济参与者在低利率或高流动性供应之间做出最优选择,从而建立信用关系。后者基于代理人的资产负债表,可以确定银行在市场上最优提供的流动性供应和利率。基于公共和私人信号之间的结合,金融机构通过能够生成动态网络的优先依附演化过程,随着时间的推移,创建或切断其信用连接。研究结果表明,核心-外围银行同业网络的出现,加上贷款人和借款人规模的一定程度的同质性,是确保系统弹性的基本特征。此外,强化学习最优政策建议在减轻替代政策工具的系统性风险方面发挥着至关重要的作用。

论文链接:https://arxiv.org/pdf/2204.07134.pdf

阅读详情

标题:Efficient and practical quantum compiler towards multi-qubit systems with deep reinforcement learning(面向深度强化学习多量子比特系统的高效实用量子编译器)

简介:高效的量子编译策略极大地增强了量子计算机执行复杂量子算法的能力。然而,当前协议低优化性、推理时间长、可扩展性有限以及缺乏通用性。为此,本文设计了高效实用的量子编译器,并辅以先进的深度强化学习 (RL) 技术,即数据生成、深度 Q 学习和 AQ* 搜索。该协议兼容各种量子机器,可用于编译多量子比特算子。在单量子位算子编译任务中,该方法在编译序列长度和推理时间方面优于其他基于 RL 的量子编译器。同时,输出解接近最优,由 Solovay-Kitaev 定理保证。值得注意的是,对于无逆通用基组,所获得的序列长度复杂度与基于逆的设置相当,并显着改进了现有方法。这些经验结果有助于改进无逆Solovay-Kitaev定理。此外,其首次展示了如何利用基于 RL 的量子编译器来完成双量子位算子编译。所取得的成果为RL与量子编译的结合开辟了一条途径,将效率和实用性统一起来,从而促进量子优势的探索。

论文链接:https://arxiv.org/pdf/2204.06904.pdf

阅读详情

标题:Modularity benefits reinforcement learning agents with competing homeostatic drives(模块化有益于强化学习智能体与竞争性稳态驱动)

简介:平衡冲突需求的问题是智力的基础。标准强化学习算法最大化标量奖励,这需要将不同的目标特定奖励组合成一个数字。或者,不同的目标也可以在行动价值的层面上进行组合,这样负责不同目标的专家模块向决策过程提交不同的行动建议,每一个都基于相互独立的奖励。本文探讨了这种替代策略的潜在好处。并研究了一个与生物学相关的多目标问题,即一组变量的持续稳态,并将单一深度 Q 网络与每个变量都有专用 Q 学习器的模块化网络进行比较。研究发现模块化智能体:a)需要最少的外源性探索;b) 提高了采样效率;c)对域外扰动更具鲁棒性。

论文链接:https://arxiv.org/pdf/2204.06608.pdf

阅读详情

标题:Improving adaptability to new environments and removing catastrophic forgetting in Reinforcement Learning by using an eco-system of agents( 通过智能体生态系统提高强化学习对新环境的适应性和消除灾难性遗忘)

简介:由于对训练环境的典型过度拟合,使强化学习 (RL) 智能体适应看不见的环境是一项艰巨的任务。RL 代理通常能够解决非常接近训练环境的环境,但是当环境变得大不相同时,它们的性能会迅速下降。当代理在新环境中重新训练时,会出现第二个问题:存在灾难性遗忘的风险,在这种情况下,以前见过的环境的性能会受到严重阻碍。本文提出了一种利用代理生态系统来解决这两个问题的新方法。因此,个体代理的(有限的)适应性能力被收获,以建立一个高度适应性的生态系统。这允许将部分工作量从学习转移到推理。在两种不同的环境分布上对该方法的评估表明,我们的方法在适应性/泛化方面优于最新技术,并且避免了灾难性遗忘。

论文链接:https://arxiv.org/pdf/2204.06550.pdf

阅读详情

标题:RL-CoSeg : A Novel Image Co-Segmentation Algorithm with Deep Reinforcement Learning(RL-CoSeg:一种新颖的深度强化学习图像协同分割算法)

简介:本文提出了基于深度强化学习(RL)的自动图像协同分割算法。该研究为首次将 RL 方法应用于协同分割的工作。其将问题定义为马尔可夫决策过程 (MDP),并通过具有异步优势 Actor-Critic (A3C) 的 RL 对其进行优化。RL 图像协同分割网络使用图像之间的相关性从一组相关图像中分割常见和显着对象。为了实现自动分割, RL-CoSeg 方法消除了用户的提示。针对图像协同分割问题,提出了基于 A3C 模型的协作 RL 算法。并提出了 Siamese RL 协同分割网络结构,以获得图像的共关注以进行共分割。其改进了自动强化学习算法的自注意力以获得长距离依赖并扩大了感受野。通过自注意获得的图像特征信息可以用来补充被删除用户的提示,帮助获得更准确的动作。实验结果表明,该方法在粗略和精细的初始分割上都可以有效地提高性能,并且在 Internet 数据集、iCoseg 数据集和 MLMR-COS 数据集上实现了最先进的性能。

论文链接:https://arxiv.org/ftp/arxiv/papers/2204/2204.05951.pdf

阅读详情

标题:Automated Atomic Silicon Quantum Dot Circuit Design via Deep Reinforcement Learning(基于深度强化学习的原子硅量子点电路自动设计)

简介:强大的自动化设计工具对于任何计算技术的扩散都至关重要。本文介绍了首次用于硅悬挂键量子点计算技术的自动化设计工具,其为非常通用和灵活的单原子计算电路框架。自动设计师能够通过使用tabla-rasa双深度Q-学习强化学习算法,在任意大小的设计区域和真值表的复杂超维设计空间中导航。对于大范围的双输入单输出逻辑电路和双输入双输出半加法器,证明了鲁棒策略收敛性。与文献中唯一的另一个半加法器相比,该半加法器在几个数量级的时间内设计的SIDB数量级更少。本文预计,基于强化学习的自动化设计工具将加速SiDB量子点计算技术的发展,最终在专用计算硬件中得到采用。

论文链接:https://arxiv.org/pdf/2204.06288.pdf

阅读详情

标题:Discovering diverse solutions in deep reinforcement learning by maximizing state-action-based mutual information(通过最大化基于状态动作的互信息在深度强化学习中发现不同的解决方案)

简介:强化学习算法通常仅限于学习特定任务的单一解决方案,即使经常存在不同的解决方案。最近的研究表明,学习一组不同的解决方案是有益的,因为多样性可以实现稳健的小样本适应。尽管现有方法通过使用互信息作为无监督奖励来学习不同的解决方案,但这种方法通常会受到由值函数逼近引起的梯度估计的偏差。本文提出了一种新方法,可以学习不同的解决方案而不会遇到偏差问题。在本文的方法中,通过直接最大化互信息的变分下限来训练以连续或离散潜在变量为条件的策略,而不像以前研究使用互信息作为无监督的奖励。机器人运动任务的广泛实验证明了所提出的方法成功地学实现了一个通过学习连续的潜在变量来获得无限的不同解决方案。并且与现有方法相比,本文的方法能够实现更有效的小样本适应。

论文链接:https://www.sciencedirect.com/science/article/pii/S0893608022001393?via%3Dihub

阅读详情

标题:Risk-based implementation of COLREGs for autonomous surface vehicles using deep reinforcement learning(基于风险的自主水面船舶COLREGs的深度强化学习实现)

简介:自主式海上船舶可以减少环境影响,降低成本,提高效率。尽管仍然需要密切监控以确保安全,但最终目标是实现完全自主。里程碑是开发一个多功能的控制系统,足以应对任何天气和遭遇,同时也具有鲁棒性和可靠性。此外,控制系统必须遵守国际海上避碰规则(COLREGs),以便与人类水手成功互动协作。因为COLREGs是为人类的思维而写的,不可机器阅读或验证。由于这些挑战和需要解决的各种情况,基于经典模型的方法被证明很难实现。DRL的无模型和自学习特性使其成为一种很有前途的自主船舶候选。本文使用碰撞风险理论将COLREGs的一个子集合并到基于DRL的路径跟踪和避障系统中。在训练场景、孤立遭遇场景和基于AIS的真实场景模拟中,生成的自主智能体在路径跟踪和符合COLREGs的冲突避免之间动态插值。

论文链接:https://www.sciencedirect.com/science/article/pii/S0893608022001435

阅读详情

标题:Hybrid Reinforcement Learning for Optimal Control of Non-Linear Switching System(非线性切换系统最优控制的混合强化学习)

简介:基于强化学习机制,提出了一种基于数据的方案来解决离散时间非线性切换系统的最优控制问题。切换系统中,控制信号由活动模式(离散)和控制输入(连续)组成。本文首先推导了混合动作空间的Hamilton-Jacobi-Bellman方程,并提出了一种两阶段值迭代的方法来学习最优解。此外,通过将Q函数分解为价值函数和归一化优势价值函数,设计了一个神经网络结构,该函数对于子系统的连续控制是二次的。这样,Q函数和连续策略可以在每个迭代步骤同时更新,从而将混合策略的训练简化为一步的方式。此外,在考虑逼近误差的情况下,给出了该算法的收敛性分析。最后,通过三个不同的仿真实例对该算法进行了应用评估。

论文链接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=9756440

阅读详情

标题:Average reward adjusted deep reinforcement learning for order release planning in manufacturing(深度强化学习调整制造业订单发布计划的平均奖励)

简介:生产计划中的关键挑战之一,尤其是在离散制造中,是确定何时将哪些订单下达到车间。此计划任务的主要目的是平衡在制品(WIP)和利用率水平,以及及时完成订单。生产计划的两个最重要的属性是(i)在制品、流程时间和产量之间的高度非线性关系,以及(ii)动态变化的环境。尽管如此,大多数最先进的模型使用静态交货时间来解决这个问题。直到最近,一些研究才根据流动时间预测动态设置提前期,以对报告预期结果的动态操作特征做出反应。本文通过介绍使用强化学习 (RL) 随时间动态设置交货时间的订单发布模型,为这一研究领域做出了贡献。应用的 RL 智能体专为具有周期性反馈和高度可变上下文的过程而设计。本文通过使用多阶段、多产品流水车间模拟模型进行算法比较试验,获得良好的结果。

论文链接:https://www.sciencedirect.com/science/article/pii/S0950705122003598

阅读详情

标题:A Study of Causal Confusion in Preference-Based Reward Learning(基于偏好的奖励学习中的因果混淆研究)

简介:通过基于偏好的奖励学习来学习机器人策略是一种越来越流行的定制机器人行为的方法。然而,越来越多的证据表明,从偏好中学习奖励函数容易产生虚假的相关性。在强化学习中,有很多关于因果混淆的经验和理论分析,这些方法直接从状态映射到行为。本文首次在从偏好学习奖励函数的背景下,对因果混淆进行了系统研究。 为了促进这项研究,作者确定了一组三个偏好学习基准域,在从成对轨迹偏好的离线数据集中学习时观察到因果混淆。为了深入了解这种观察到的因果混淆,作者提出了一项敏感性分析,探讨了不同因素(包括训练数据类型、奖励模型容量和特征维度)对从偏好中学习到的奖励的稳健性的影响。作者发现有证据表明,从成对轨迹偏好中学习奖励对虚假特征和增加的模型容量高度敏感且不鲁棒,但对训练数据的类型不敏感。

论文链接:https://arxiv.org/pdf/2204.06601.pdf

阅读详情

标题:An Analysis of Discretization Methods for Communication Learning with Multi-Agent Reinforcement Learning(基于多智能体强化学习的通信学习离散化方法分析)

简介:当智能体无法观察环境的完整状态时,通信在多智能体强化学习中至关重要。允许在智能体之间进行学习通信的最常见方法是使用可区分的通信通道,该通道允许梯度作为反馈形式在智能体之间流动。然而,当我们想要使用离散消息来减少消息大小时,这是具有挑战性的,因为梯度不能通过离散的通信通道流动。以前的工作提出的方法在不同的架构和环境中进行测试,很难进行比较。作者在通信学习的背景下使用来自其他智能体的梯度进行此比较,并在多个环境中执行测试。结果表明,没有一种方法在所有环境中都是最好的。离散化方法的最佳选择很大程度上取决于环境。然而,离散正则化单元 (DRU)、直通 DRU 和直通 gumbel softmax 在所有测试环境中显示出最一致的结果。因此,这些方法被证明是一般使用的最佳选择。

论文链接:https://arxiv.org/pdf/2204.05669.pdf

阅读详情

标题:Multi-agent Actor-Critic with Time Dynamical Opponent Model(具有时间动态对手模型的多智能体 Actor-Critic)

简介:在多智能体强化学习中,多个智能体在与公共环境以及彼此交互的同时同时学习。由于智能体在学习过程中调整了他们的策略,不仅单个智能体的行为变得不稳定,而且智能体感知的环境也变得不稳定。本文利用智能体寻求提高其预期累积奖励的事实,并引入一种新颖的时间动态对手模型(TDOM)来编码对手策略随着时间推移趋于改善的知识。通过推导单个代理的日志目标的下限在理论上激励TDOM,并进一步提出了具有时间动态对手模型 (TDOM-AC) 的多代理Actor-Critic。凭经验表明,TDOM在测试期间实现了出色的对手行为预测。 所提出的TDOM-AC方法在合作,特别是在混合的合作-竞争环境中执行的实验上优于最先进的 Actor-Critic 方法,且能更稳定的训练和更快的收敛。

论文链接:https://arxiv.org/pdf/2204.05576.pdf

阅读详情

标题:Safe Reinforcement Learning Using Black-Box Reachability Analysis(基于黑箱可达性分析的安全强化学习)

简介:强化学习(RL)能够在不确定环境中对机器人进行复杂的运动规划和控制。然而,最先进的深度RL方法通常缺乏安全保证,尤其是在机器人和环境模型未知的情况下。为了证明广泛部署的合理性,机器人必须在不牺牲性能的情况下遵守安全约束。因此,本文提出了一种基于黑箱可达性的安全层(BRSL),它由三个主要部分组成:(1)黑箱机器人模型的数据驱动可达性分析,(2)使用在线训练的神经网络集合预测未来动作和观察的轨迹规划器,(3)可达集和障碍物之间的可微多面体碰撞检查,可以纠正不安全行为。在模拟中,BRSL在Turtlebot 3、四旋翼和轨迹跟踪点质量上优于其他最先进的安全RL方法,其中不安全集与最高奖励区域相邻。

论文链接:https://arxiv.org/pdf/2204.07417.pdf

阅读详情

研究综述

标题:东北大学 | 图强化学习研究综述

简介:图挖掘任务来自许多不同的应用领域,从社交网络、交通运输、电子商务等,近年来受到理论和算法设计界的高度关注,并有一些开创性的研究使用热心研究强化学习(RL)技术来解决图数据挖掘任务。本文提供了 RL 模型和图挖掘的全面概述,将这些算法作为一个统一的公式推广到图强化学习 (GRL)。并进一步讨论了 GRL 方法在各个领域的应用,总结了方法描述、开源代码、和 GRL 方法的基准数据集。最后,其提出了未来可能需要解决的重要方向和挑战。这是对 GRL 文献进行全面调查的最新工作,这项工作为研究人员提供了全局视野,也为领域外的研究人员提供了学习资源。此外,本文为想要进入这个快速发展的领域的感兴趣的研究人员和想要比较 GRL 方法的专家创建了一个在线开源软件。

论文链接:https://arxiv.org/ftp/arxiv/papers/2204/2204.06127.pdf

阅读详情

如果你正在从事或关注强化学习研究、实现与应用,欢迎加入“智源社区-强化学习-交流群”。在这里,你可以:

学习前沿知识、求解疑难困惑

分享经验心得、展示风貌才华

参与专属活动、结识研究伙伴

请扫描下方二维码加入。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢