ChatGPT功能强大,用来做坏事也会效率很高,因此文本是否AI生成的分类器/检测模型是一种刚需。

在GPTZero和斯坦福大学的DetectGPT之后,OpenAI的官方工具也发布了:

https://openai.com/blog/new-ai-classifier-for-indicating-ai-written-text/

中国用户还是不能使用。而且没有论文……博客里只有这么一段原理性的介绍:

我们的分类器是一种语言模型,针对同一主题的人工文本和 AI 文本对的数据集进行了微调。 从我们认为是由人类编写的各种来源收集了这个数据集,例如预训练数据和提交给 InstructGPT 的人类演示。 我们将每个文本分为提示和响应。 根据这些提示,我们生成了来自我们和其他组织训练的各种不同语言模型的响应。对于网页应用,我们调整置信度阈值以保持较低的误报率; 换句话说,如果分类器非常有信心,我们只会将文本标记为可能是 AI 编写的。

唉,OpenAI是不是应该改名字了?

从官方博客来看,这个分类器效果还不够好:

我们的分类器并不完全可靠。 在对英语文本“挑战集”的评估中,我们的分类器正确地将 26% 的 AI 编写文本(真阳性)识别为“可能是 AI 编写的”,同时错误地将 9% 的人类编写文本标记为 AI 编写的(误报)。 分类器的可靠性通常会随着输入文本长度的增加而提高。与我们之前发布的分类器相比,这个新的分类器在来自更新一些的 AI 系统的文本上的可靠性要高得多。

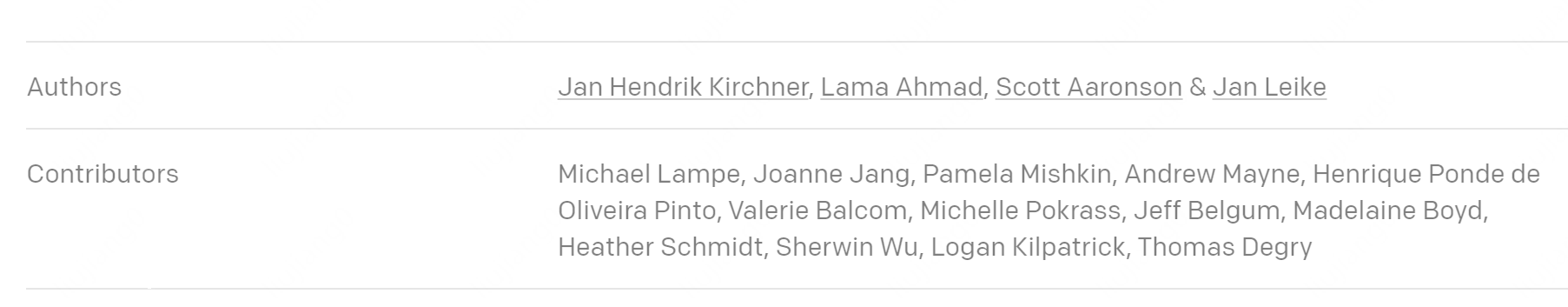

有意思的是,在作者一行发现了一个熟悉的名字:量子计算大V、德克萨斯奥斯汀分校的Scott Aaronson。他的个人网站上确实写着目前休假,到OpenAI工作,从事AI安全性的基础研究。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢