关于周刊:

强化学习作为人工智能领域研究热点之一,其研究进展与成果也引发了众多关注。为帮助研究与工程人员了解该领域的相关进展和资讯,智源社区结合领域内容,撰写为第53期《强化学习周刊》。本期周刊整理了强化学习领域相关的最新论文推荐及研究综述,以飨诸位。

周刊采用社区协作的模式产生,欢迎感兴趣的朋友们参与我们的工作,一起来推动强化学习社群的分享、学习和交流活动。可以扫描文末的二维码加入强化学习社区群。

本期贡献者:(李明,刘青、小胖)

关于周刊订阅:

告诉大家一个好消息,《强化学习周刊》开启“订阅功能”,以后我们会向您自动推送最新版的《强化学习周刊》。订阅方法:

1,注册智源社区账号

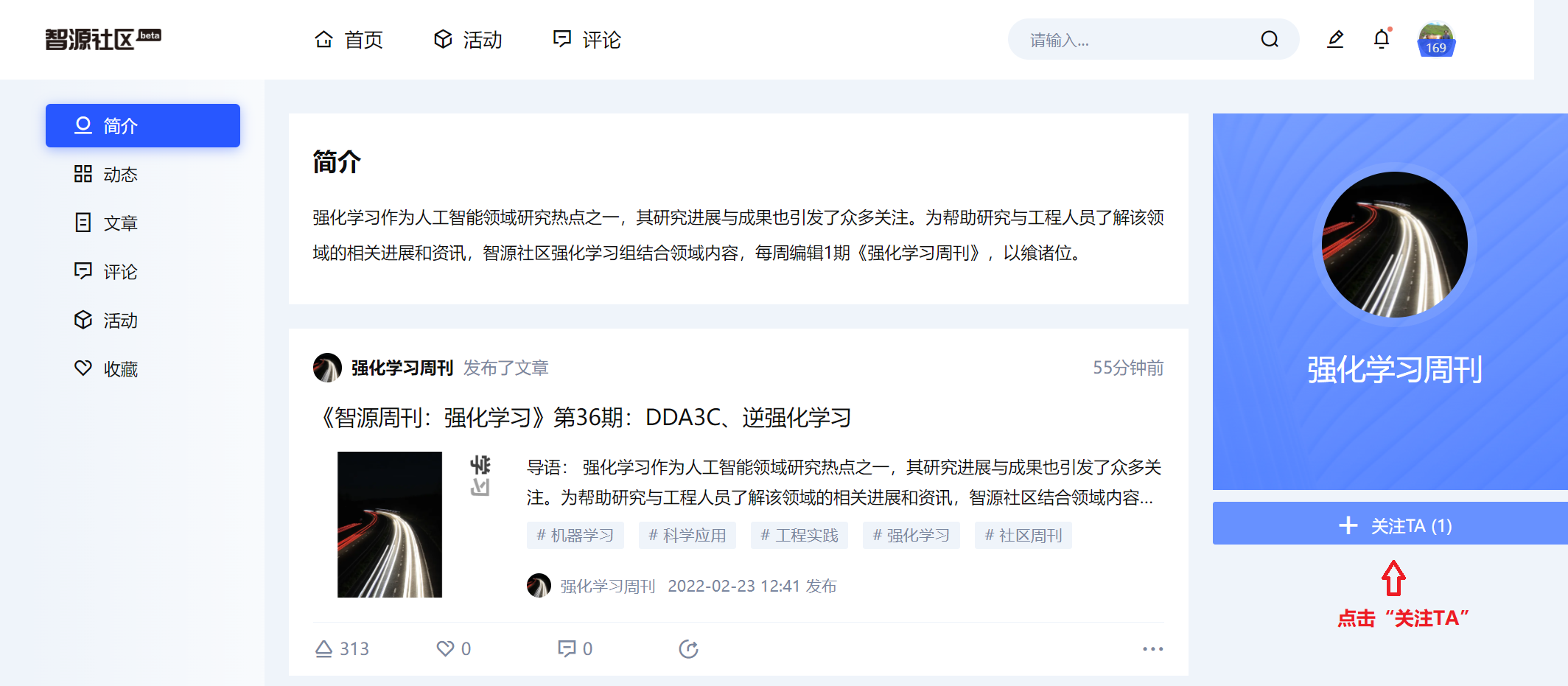

2,点击周刊界面左上角的作者栏部分“强化学习周刊”(如下图),进入“强化学习周刊”主页。

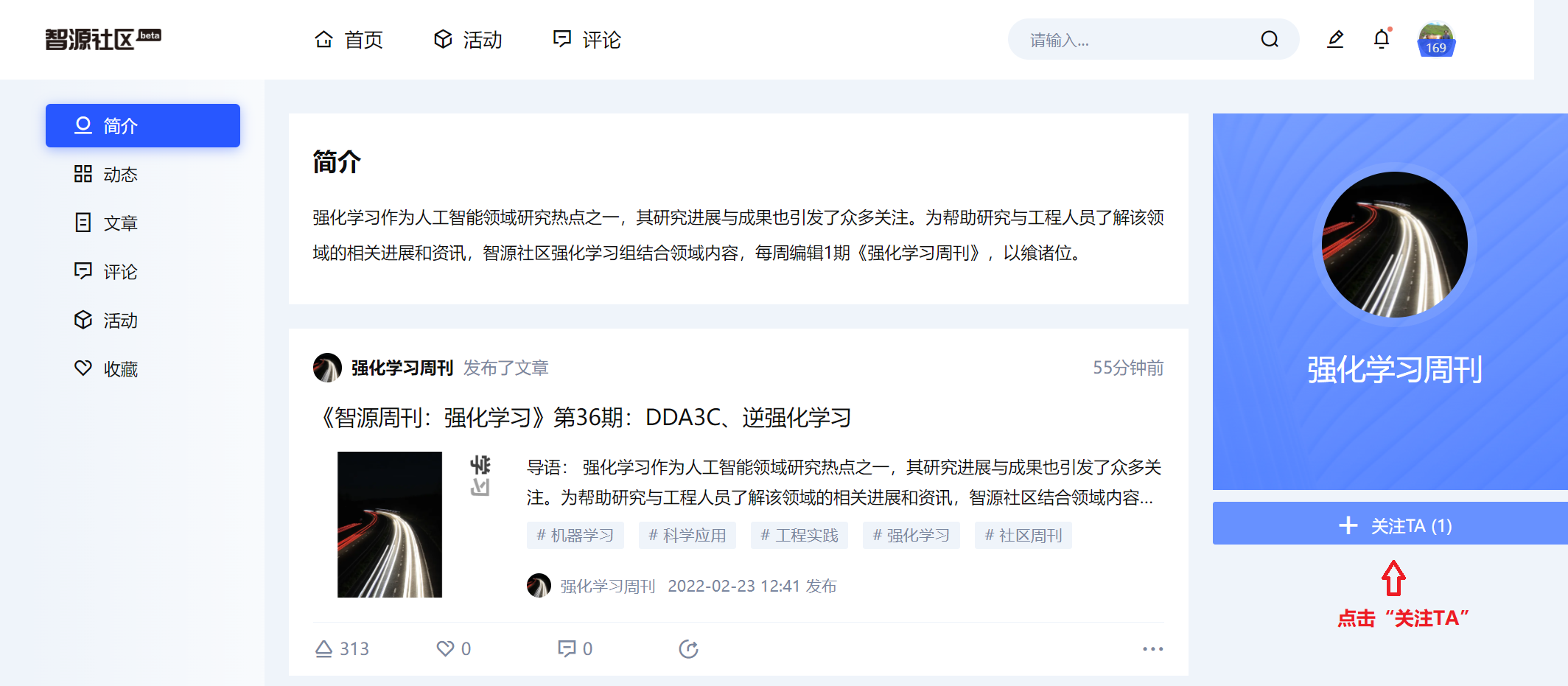

3,点击“关注TA”(如下图)

4,您已经完成《强化学习周刊》订阅啦,以后智源社区会自动向您推送最新版的《强化学习周刊》!

论文推荐

本次推荐了14篇强化学习领域的相关论文,主要介绍了基于多智能体DRL方法的无人机分散学习策略、提出了近似策略优化(PPO)方法预测交通需求以降低实际运行成本、基于动态屏蔽技术显著减少训练期间意外事件的数量、通过领域泛化自动增强方法提高视网膜图像分割领域泛化性能、基于软actor-critic 的DRL 警报优先级算法(SAC-AP)以最大化预期奖励及最大化熵 、基于对抗的域不变状态表示提高RL的灵活性、最后介绍了增强和主动学习方法REMEDIER(基于增强的CEP pattErn MinER)以充分挖掘CEP模式等。

标题:Playing a 2D Game Indefinitely using NEAT and Reinforcement Learning(Pune Institute of Computer Technology:Jerin Paul Selvan | 使用 NEAT 和强化学习无限期玩 2D 游戏)

简介:十多年来,机器人技术和人工智能体的使用已成为普遍现象。人工智能体可根据算法在其所处的环境中的行为进行操作。其能够以多快的速度区分奖励行为和敌对行为,目标是通过对能够避免所有障碍的行动做出决策来达到最远的目标。本文选择名为“Flappy Bird”的游戏,其目标是让鸟穿过一组随机高度的管道。鸟必须进入这些管道之间,不得撞击顶部、底部或管道本身。鸟可以采取的动作是拍动翅膀或在重力作用下坠落。在人工智能体上实施的算法是增强拓扑的神经进化(NEAT)和增强学习。NEAT算法采用人工智能体的“N”初始种群。它们遵循遗传算法,考虑目标函数、交叉、变异和增广拓扑。强化学习记住状态、在该状态下采取的行动以及使用单个智能体和深度Q学习网络采取的行动所获得的奖励。随着人工智能体初始种群的增加,NEAT算法的性能得到提高。

论文链接:https://arxiv.org/pdf/2207.14140.pdf

阅读详情

标题:Decentralized Computation Offloading With Cooperative UAVs: Multi-Agent Deep Reinforcement Learning Perspective(Korea University: Inkyu Lee | 协同无人机的分散计算卸载:多智能体深度强化学习视角)

简介:物联网(IoT)节点的有限计算资源在处理输入数据时会产生令人望而却步的延迟。在现有基站部署计算服务器可能不足以支持在恶劣环境中运行的物联网节点。这要求在提供按需移动边缘计算(MEC)服务的无人机(UAV)上安装移动边缘服务器。无人机随时间变化的卸载需求和机动性需要针对所有时间实例联合设计优化变量。因此,在线决策机制对于无人机辅助MEC网络至关重要。本文以在线方式对无人机和物联网节点进行决策,从DRL的角度解决了任务卸载、资源分配和无人机机动性的联合优化问题。对于分散实现,提出了一种多智能体DRL方法,其中多个智能无人机在没有中央协调的情况下协作确定其计算和通信策略。数值结果表明,该分散学习策略优于现有的DRL解。该框架揭示了分散DRL技术在设计自组织物联网中的可行性。

论文链接:https://arxiv.org/pdf/2207.13832.pdf

阅读详情

标题:Multi-Objective Provisioning of Network Slices using Deep Reinforcement Learning(King's College London:Chien-Cheng Wu | 使用深度强化学习的多目标网络切片配置)

简介:网络切片(NS)对于在下一代网络中有效实现不同的网络应用至关重要。尽管如此,复杂的服务质量(QoS)要求和网络服务中的不同异构性要求网络切片供应(NSP)优化需要很高的计算时间。传统的优化方法在满足网络应用的低延迟和高可靠性方面具有挑战性。为此,本文将实时NSP建模为在线网络片供应(ONSP)问题。其将ONSP问题表述为在线多目标整数规划优化(MOIPO)问题。然后,通过将近似策略优化(PPO)方法应用于交通需求预测来近似求解MOIPO问题。仿真结果表明,与最先进的MOIPO解算器相比,该方法具有更低的SLA违反率和网络运行成本。

论文链接:https://arxiv.org/pdf/2207.13821.pdf

阅读详情

标题:Dynamic Shielding for Reinforcement Learning in Black-Box Environments(Kyoto University:Masaki Waga | 黑箱环境中强化学习的动态屏蔽)

简介:由于学习过程中缺乏安全保障,在网络物理系统中使用强化学习(RL)具有挑战性。虽然有各种各样的建议来减少学习过程中的不良行为,但大多数这些技术都需要先验的系统知识,其适用性有限。本文旨在减少学习过程中的不良行为,而不需要任何先验系统知识。其提出了动态屏蔽:一种基于模型的安全RL技术的扩展,称为使用自动机学习的屏蔽。动态屏蔽技术使用RPNI算法的变体与RL并行构建近似系统模型,并抑制由于从学习模型构建屏蔽而产生的不希望的探索。通过这种组合,在智能体感应到潜在的不安全行为之前,可以预见到这些行为。实验表明,所提出的动态屏蔽显著减少了训练期间意外事件的数量。

论文链接:https://arxiv.org/pdf/2207.13446.pdf

阅读详情

标题:A Contact-Safe Reinforcement Learning Framework for Contact-Rich Robot Manipulation(清华大学陈建宇教授团队 | 基于接触丰富机器人操作的接触安全强化学习框架)

简介:强化学习在解决复杂的接触丰富的机器人操作任务方面显示出巨大的潜力。然而,在现实世界中使用RL的安全性是一个关键问题,因为当RL策略在训练期间或在不可见的场景中不完善时,可能会发生意外的危险碰撞。本文提出了接触安全的强化学习框架,用于接触丰富的机器人操作,该框架在任务空间和关节空间都保持了安全性。当RL策略导致机器人手臂和环境之间发生意外碰撞时,该框架能够立即检测到碰撞,并确保接触力较小。此外,末端执行器被强制执行以顺应地执行接触丰富的任务,同时保持对外部干扰的鲁棒性。最后在仿真中训练RL策略,并将其转移到真实的机器人上。机器人擦拭任务的真实实验表明,该方法能够在任务空间和关节空间中保持较小的接触力,即使策略处于意外碰撞的不可见场景下,同时拒绝主任务上的干扰。

论文链接:https://arxiv.org/pdf/2207.13438.pdf

阅读详情

标题:AADG: Automatic Augmentation for Domain Generalization on Retinal Image Segmentation(南方科技大学:Xiaoying Tang | AADG:视网膜图像分割领域泛化的自动增强)

简介:卷积神经网络已广泛应用于医学图像分割,并取得了可观的性能。然而,其性能可能会受到训练数据(源域)和测试数据(目标域)之间的域差距的显著影响。为此,本文提出了基于数据操作的领域泛化方法,称为领域泛化自动增强(AADG)。其有效地对生成新域的数据增强策略进行采样,并在适当的搜索空间中使训练集多样化。并通过新智能体任务,最大限度地提高了多个增强新域之间的多样性,如单位球空间中的 Sinkhorn 距离所测量的那样,使自动增强易于处理。采用对抗训练和深度强化学习来有效搜索目标。在11个公开的眼底图像数据集(4个用于视网膜血管分割,4个用于视盘和视盘(OD/OC)分割,3个用于视网膜病变分割)上进行了定量和定性实验。进一步涉及两个用于视网膜血管分割的OCTA数据集,以验证跨模式泛化。该AADG具有最先进的泛化性能及相当大的优势。经验证明,所学习的策略是模型不可知的,并且可以很好地转移到其他模型。

论文链接:https://arxiv.org/pdf/2207.13249.pdf

阅读详情

标题:Deep Reinforcement Learning for End-to-End Network Slicing: Challenges and Solutions(内布拉斯加州大学: Qiang Liu|端到端网络切片的深度强化学习:挑战与解决方案)

简介:5G及更高版本有望支持垂直行业中具有不同性能要求的各种新兴应用。为经济高效地服务于这些应用,网络切片在根据特定资源需求动态创建虚拟端到端网络方面发挥着关键作用。一个网络切片可能在多个技术域上具有数百个可配置参数,其定义了网络切片的性能,并无法使用传统的基于模型的解决方案来协调网络切片的资源。本文讨论了如何设计和部署深度强化学习(DRL)以解决网络切片问题。首先,其分析了网络切片问题,并提出了符合标准的系统架构,该架构支持5G和其他网络中基于DRL的解决方案。其次,深入分析了在网络切片系统中设计和部署DRL所面临的挑战。第三,探索了多种有前途的技术,即安全和分布式DRL,以及模拟学习,以实现端到端网络切片的自动化。

论文链接:https://arxiv.org/pdf/2207.14766.pdf

阅读详情

标题:Deep Reinforcement Learning for System-on-Chip: Myths and Realities(EpiSci: Tegg Taekyong Sung|片上系统的深度强化学习:神话与现实)

简介:基于深度强化学习(DRL)的神经调度器在解决现实世界的资源分配问题方面显示出了巨大的潜力,因为它们在集群计算领域表现出了显著的性能增益。本文通过大量实验并与非神经启发式调度算法进行比较,关键发现有三个方面。首先,由于SoC计算资源的异构性和传入作业中的随机性导致的可变动作集,为集群计算领域设计的神经调度器在SoC中不能很好地工作。其次,本文新颖的神经调度器技术——折衷交互匹配 (EIM) 克服了上述挑战。基于 EIM 的神经调度器可极大地提升性能。第三,使用EIM,平均处理元素(PE)切换延迟和平均PE计算时间的比率也会显著影响神经SoC调度程序的性能。因此,未来的神经 SoC 调度器设计必须考虑这个指标以及它的实现开销以实现实用性。

论文链接:https://arxiv.org/pdf/2207.14595.pdf

阅读详情

标题:Inverse Reinforcement Learning from Diverse Third-Person Videos via Graph Abstraction(加州大学: Sateesh Kumar|通过图抽象从不同的第三人称视频中进行逆强化学习)

简介:逆向强化学习 (IRL)在消除机器人任务手动奖励设计的需求方面取得了令人鼓舞的结果。 然而,现有诸多研究仍然受到相对有限的视频领域的训练的限制。 本文认为第三人称 IRL 的真正潜力在于增加视频的多样性以实现更好的缩放。 故本文建议对视频进行图抽象,然后在图空间中进行时间匹配以衡量任务进度。 其通过形成图的实体交互来描述任务,这种图抽象可以帮助去除纹理等不相关信息,从而产生更强大的奖励函数。 本文评估 GraphIRL方法,在 X-MAGICAL 中的交叉体现学习和从人类演示中学习以进行真实机器人操作。 该方法展示了对各种视频演示的鲁棒性的显着改进,甚至在真正的机器人推动任务上取得了比手动奖励设计更好的结果。

论文链接:https://arxiv.org/pdf/2207.14299.pdf

阅读详情

标题:SAC-AP: Soft Actor Critic based Deep Reinforcement Learning for Alert Prioritization(BITS Pilani: Lalitha Chavali|SAC-AP:基于 Soft Actor Critic 的深度强化学习用于警报优先级)

简介:入侵检测系统(IDS)会产生大量的假警报, 警报优先级在决定从 IDS 生成的大量警报中调查哪些警报方面至关重要。 最近,基于深度强化学习 (DRL) 的深度确定性策略梯度 (DDPG) 离策略方法在警报优先级方面取得了更好的结果。 但DDPG易过拟合。 此外,它的探索能力也很差,因此不适合随机环境的问题。 为了解决这些限制,本文提出了一种基于软actor-critic 的DRL 警报优先级算法(SAC-AP),这是一种离线策略方法,基于最大熵强化学习框架,旨在最大化预期奖励同时也最大化熵 。 此外,将对手和防御者之间的交互建模为零和博弈,并利用双预言框架获得近似混合策略纳什均衡(MSNE)。 实验结果表明,与基于 DDPG 的警报优先级方法相比,SAC-AP 可将防御者的损失降低多达 30%。

论文链接:https://arxiv.org/ftp/arxiv/papers/2207/2207.13666.pdf

阅读详情

标题:Hierarchical Multi-agent Model for Reinforced MedicalResource Allocation with Imperfect Information(清华大学&香港科技大学: Qianyue Hao|不完全信息下强化医疗资源分配的分层多智能体模型)

简介:面对COVID-19的爆发,医疗资源短缺问题日益突出。因此,迫切需要有效的医疗资源配置策略。无模型强化学习(RL)在决策制定方面非常强大,但通过 RL 解决这个问题存在三个关键挑战:(1)现实世界中复杂的情况和无数的决策选择;(2)由于大流行传播的潜伏期,只能获得不完善的信息;(3) 在现实世界中进行实验的限制,因为不能任意设定大流行的爆发。本文提出了分层强化学习框架,通过分解的动作空间和相应的训练算法来处理无数的选择并确保有效和实时的策略。并设计了基于循环神经网络的框架来利用从环境中获得的不完美信息。此外还设计了多智能体投票方法,在模型训练期间考虑到随机性来修改决策过程,从而提高性能。以基于真实世界数据的大流行传播模拟器,作为实验平台。结果表明,该方法优于所有的基线。

论文链接:https://dl.acm.org/doi/pdf/10.1145/3552436

阅读详情

标题:Adaptive talent journey: Optimization of talents’ growth path within a company via Deep Q-Learning(意大利福贾大学: Alfonso Guarino|适应性人才之旅: 通过深度 Q 学习优化企业内部人才成长路径)

简介:本文提出了适应性人才之旅,一种优化企业内部人才成长路径的新方法。适应性人才之旅的最终目标是将人才留在公司内部。它利用“数字孪生”的概念来定义一个人才的数字表示,即人才数字孪生,建立在技能水平和个人特征的基础上。根据目标公司的角色,“适应性人才之旅”提出了最合适的工作经历(旅程)路径,以提高人才的技能,从而达到目标角色的要求。这种机制与强化学习范式产生共鸣,特别是与深度 Q 学习。该方法利用: (i)两个双深度 Q 网络(DDQN)来选择要制作的工作经验; (ii)一个转换模块来支持 DDQN 的训练,并确保尽管有限的数据可用性良好的性能。实验结果表明,适应性人才旅程能够优化人才的成长路径。

论文链接:https://www.sciencedirect.com/science/article/pii/S0957417422014348#!

阅读详情

标题:Domain Adaptive State Representation Alignment for Reinforcement Learning(成都理工大学&电子科技大学: Dongfen Li|用于强化学习的域自适应状态表示对齐)

简介:大多数现有的 RL 模型都不能泛化,这限制了 RL 在实际应用中的泛化性和灵活性。为此,本文提出了两阶段模型,强化学习智能体在学习最佳行为策略之前学习适应视觉环境的变化。在第一阶段,采用域适应来对齐潜在特征空间中不同域的域不变状态表示的分布。本文引入特征级和像素级多粒度对抗性损失来限制域不变状态表示的学习。在第二阶段,RL 智能体基于学习到的域不变状态表示进行训练。由于调整后的观察是域不变的,因此学习到的策略具有很强的跨域泛化性能。即基于对抗的域不变状态表示(Ad-DISR)。最后,在各种赛车游戏和自动驾驶模拟器 CARLA 上评估 Ad-DISR。结果表明,此方法可以在源域和目标域的奖励分数和生存时间方面取得更好的性能。

论文链接:https://www.sciencedirect.com/science/article/pii/S0020025522008416

阅读详情

标题:Optimal control of renewable energy in buildings using the machine learning method(安徽建筑大学&杭州电子科技大学: Lirong Wang|基于机器学习方法的建筑可再生能源优化控制)

简介:本文提出利用强化学习控制方法对绿色建筑中的可再生能源进行最佳控制,以尽量减少配电部门的能源消耗和电力损耗。控制系统是根据建筑物的能源使用情况,以及为了满足可再生能源的需要以及尽可能少地使用其他能源而储存或注入环境中的能源来确定的。这种优化在建筑物的中央管理系统中得到了体现,该系统被称为建筑物能量增强学习(BEEL)。优化的 BEEL 是最大化的数值奖励的信号表示的强化学习算法,并与一个混合支持向量-小波学习算法进行比较。该方法揭示了相应的行为是基于奖励的,并且比其他代表性的机器学习方法具有更高的合规性。与人工智能方法相比,强化学习的两个独特特征是试错和延迟奖励,在这里以 99.98% 的准确率完成。

论文链接:https://www.sciencedirect.com/science/article/pii/S2213138822005847#!

阅读详情

研究综述

标题:Reinforcement learning in ophthalmology: potential applications and challenges to implementation(英国伦敦大学: Siddharth Nath|眼科强化学习:潜在应用和实施挑战)

简介:强化学习是机器学习的一种子类型,其中虚拟智能体在一组预定义的规则中运行,旨在最大化指定的结果或奖励。该智能体可以同时考虑多个变量和许多并行动作以优化其奖励,从而解决复杂的顺序问题。临床决策需要医生在设定的实践框架内优化患者结果,因此为实施强化学习驱动的解决方案提供了相当大的机会。本文提供了强化学习的概述,并专注于眼科中的潜在应用。本文还探讨了与强化学习解决方案的开发和实施相关的挑战,并讨论了解决这些问题的可能方法。

论文链接:https://www.sciencedirect.com/science/article/pii/S2589750022001285#!

阅读详情

新书籍

标题:以色列理工学院:Guy Shapira | CEP 的无监督频繁模式挖掘算法

简介:复杂事件处理 (CEP) 是一组允许使用复杂和高度描述性模式从海量数据流中有效提取知识的方法。在线金融、医疗保健监控和欺诈检测等众多应用程序使用 CEP 技术实时捕获关键警报、潜在威胁或重要通知。然而,目前许多领域缺乏人类专业知识。故本文提出新颖的增强和主动学习方法REMEDIER(基于增强的CEP pattErn MinER),该方法旨在挖掘CEP模式,允许扩展提取的知识,同时减少所需的人力。该方法包括适用于大量多元空间的新策略梯度方法,及将增强和主动学习相结合的新方法,用于CEP规则学习,同时最小化训练所需的标签数量。REDEEMER的目标是在以前无法使用的领域中实现CEP集成。REDEEMER是首个建议事先未观察到的新CEP规则的系统,也是首个旨在增加专家不具备CEP工具所需足够信息的领域中的模式知识的方法。最后在不同数据集上的实验表明,REDEEMER能够扩展模式知识,同时优于几种最先进的模式挖掘强化学习方法。

论文链接:https://arxiv.org/ftp/arxiv/papers/2207/2207.14017.pdf

阅读详情

如果你正在从事或关注强化学习研究、实现与应用,欢迎加入“智源社区-强化学习-交流群”。在这里,你可以:

学习前沿知识、求解疑难困惑

分享经验心得、展示风貌才华

参与专属活动、结识研究伙伴

请扫描下方二维码加入。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢