汇聚每周AI观点、研究和各类资源,不错过真知灼见和重要资讯!欢迎点击这里,关注并订阅智源社区AI周刊。

编辑精选

历史上,神经科学启发了研究者设计人工神经网络,成为当前深度学习的核心与技术。但近年来,AI研究面临更大的困难,研究者需要从大脑中获得更多的认知和启示。近日,包括Yoshua Bengio、Yann LeCun、Jeff Hawkins、Doris Tsao(曹颖)等AI研究者和神经科学家在内的多人发表了题为“Toward Next-Generation Artificial Intelligence: Catalyzing the NeuroAI Revolution”的论文,呼吁研究者加快NeuroAI的基础研究。

文章提出,智能的本质在于与世界进行感知运动交互的能力。同时,文章提出具身图灵测试(The Embodied Turing Test),是面向NeuroAI的挑战,其核心在于考察AI的感知运动能力。同时,文章还设想了应对具身图灵测试的技术路线。

值得一提的是,智源社区在今年9月21日举行了“智能的起源与本质”研讨会,NeuroAI论文作者之一的Jeff Hawkins和曹颖也谈到了智能与感知运动交互之间的关系。感兴趣的读者可在此观看研讨回放(YouTube):https://baai.org/l/Intelligen2022。

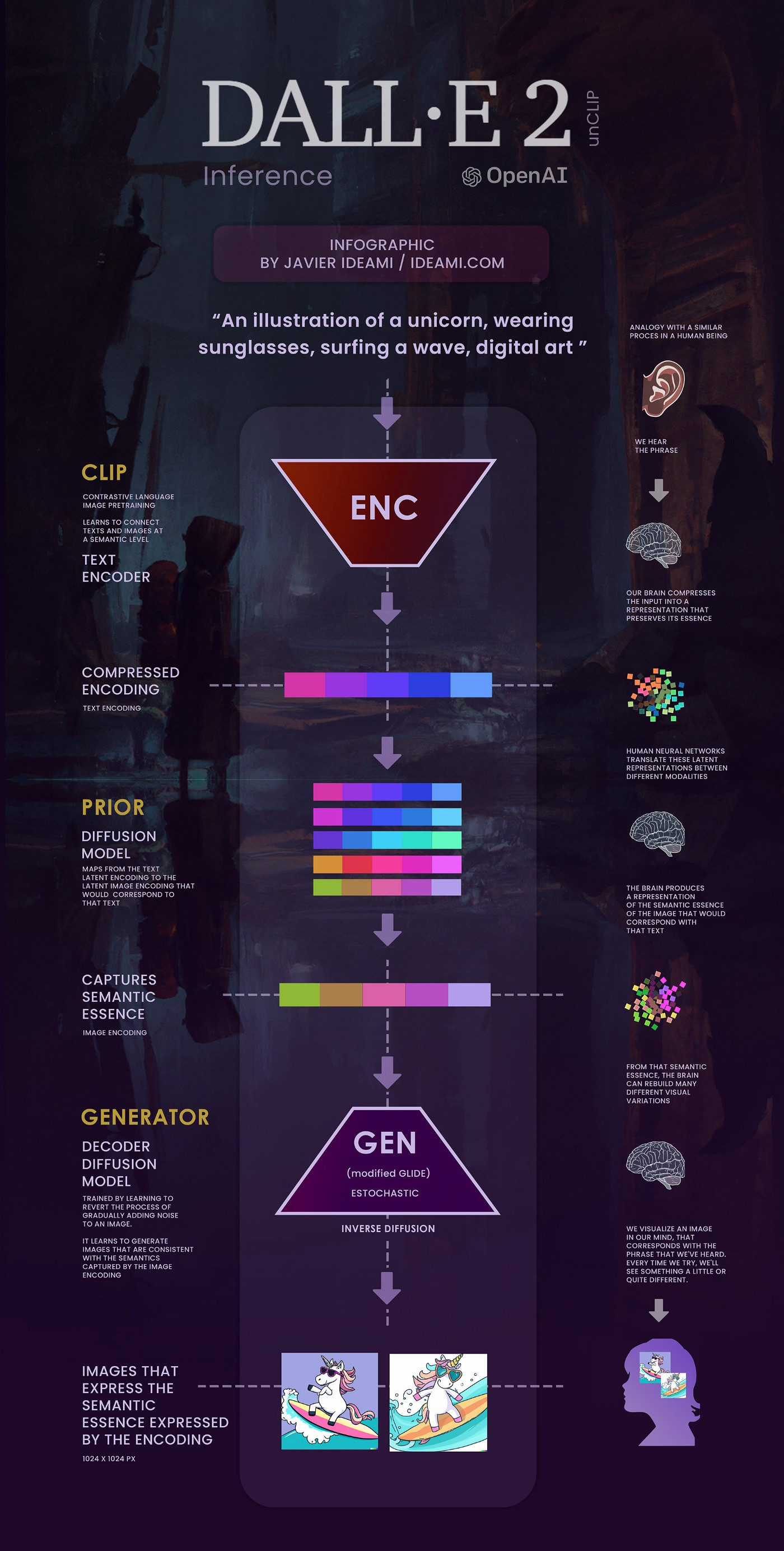

近日,Geniverse的联合创始人哈维尔·艾德米发文,从基本技术原理讲起,叙述了生成式人工智能的发展以及作者对该领域的理解。艾德米认为,大自然进化出一种机制来解决处理海量信息的机制:压缩和解压过程。我们的大脑能够获取通过感官到达的信息,并将其压缩成一种细节更少、抽象程度更高的形式。而在需要还原细节时,将压缩在隐藏空间的抽象特征还原出来。从DALLE-2 (OpenAI) 到Imagen (Google)、Stable Diffusion (Stability.ai) ,所有这些系统最初的共同基础是压缩和解压缩过程,它们允许在高细节和高抽象之间双向移动,即“扩散”。

观点

- 追一科技苏剑林:生成扩散模型漫谈,条件控制生成结果

- 菲尔兹奖得主丘成桐:人工智能与学“问”

- 一场twitter争论:人工智能是否需要神经科学?

- 吴恩达来信:Prompt engineering的现状与未来

研究前沿

- 谷歌总结的指令微调方法,30亿参数模型跑赢GPT-3

- 一行代码12倍加速Bert推理,OpenAI编程语言加持的训练引擎火热

- 北大黄铁军团队发布:视觉信息的神经解码专题综述

- 打破不可能三角、比肩5400亿模型,IDEA封神榜团队仅2亿级模型达到零样本学习SOTA

- Fast and Effective:一文速览轻量化Transformer各领域研究进展

产业

活动

- 报名 | MILA&Salesforce研究者详解:在RICE-N中对全球气候谈判、协议和长期合作进行建模(智源社区,10月31日)

- 回放 | 新加坡国立大学尤洋:快速高效AI大模型训练和部署

- 回放 | 马毅、曹颖、Karl Friston、Michael Wooldridge、Jeff Hawkins、黄铁军:从简约与自洽原则谈起——智能的起源与本质

- 回放 | 2022智源大会全体大会及各分论坛视频上线

求职招聘

- 智源研究院 | AI for Science方向研究员,探索生命科学前沿,解决世界级科研问题

- 智源研究院 | 分子动力学方向研究员,研究生物大分子动力学模拟,实现分子结构功能的预测泛化

- 智源研究院 | 类脑智能方向研究员,追踪国际前沿文献,研发具有生理功能的大规模高精度神经网络模型

- 悉尼科技大学澳大利亚人工智能研究院 | 招收全奖博士生

- 西湖大学系统神经科学与神经工程实验室 | 脑认知+深度强化学习交叉方向博士后

开源

教程

查看预训练、强化学习等领域周刊内容,欢迎点击这里。

招聘、活动、推广等合作,请联系:editor@baai.ac.cn

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢